Methodik

Zur Ermittlung der oben genannten Leitfragen wurde im August 2025 mit 156 Personen eine qualitative Umfrage mittels eines Online-Fragebogens durchgeführt.

Demografisch berücksichtigt wurden Personen der Jahrgänge 1995 bis 2010, die nach der Definition von Simon Schnetzer (2024) zur Gen Z gehören.

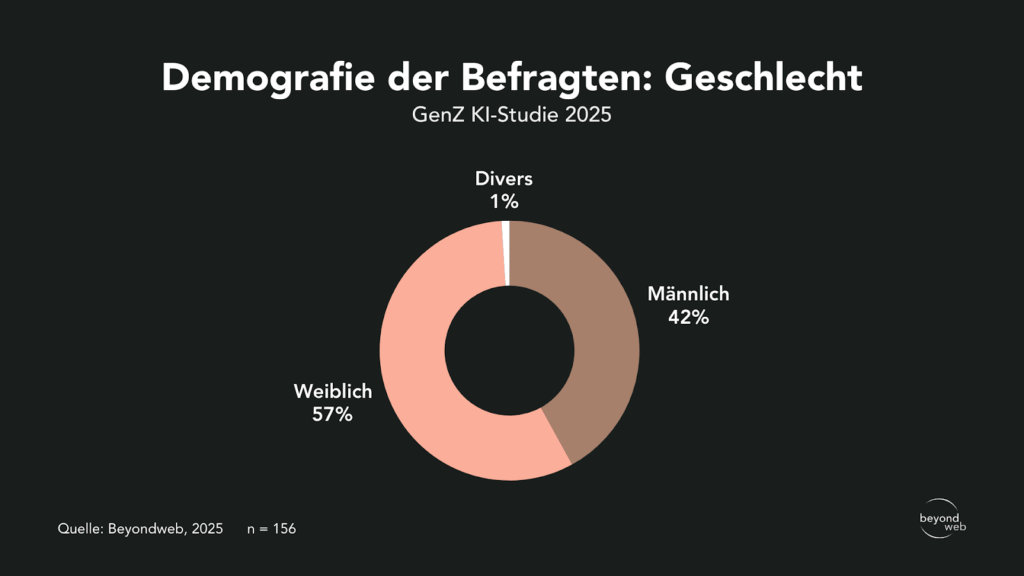

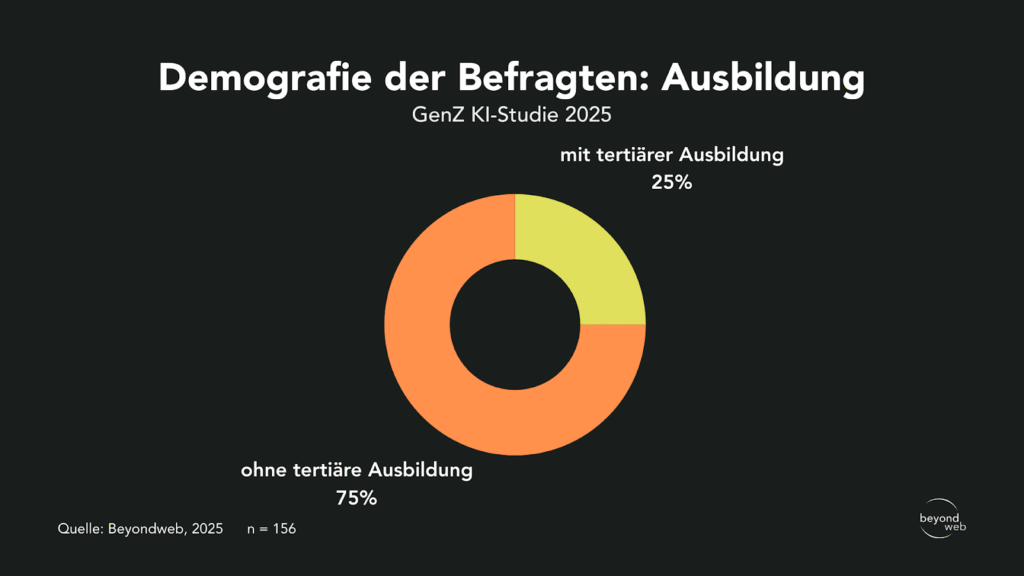

Die Befragten wurden nach Bildungsstand sowie Geschlecht segmentiert.

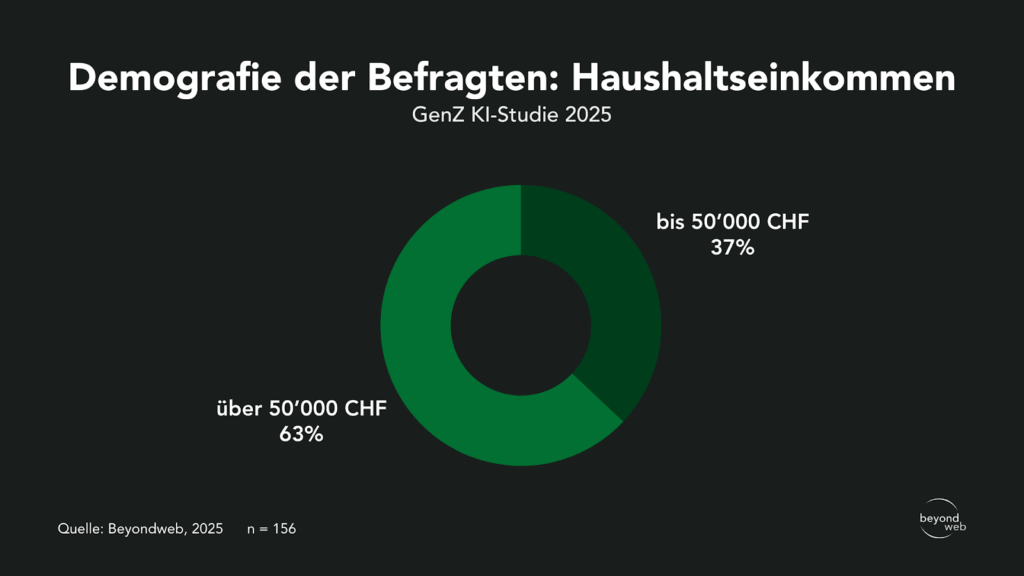

Zudem wurde das Haushaltseinkommen erhoben.

Die Qualitätssicherung der Antworten wurde mittels einer Marktforschungsplattform gewährleistet.

Die befragte Grundpopulation setzt sich folgendermassen zusammen:

- Geschlecht: 42 % männlich, 57 % weiblich, 1 % divers

- Ausbildung: 25 % mit tertiärer Bildung, 75 % ohne tertiäre Bildung

- Haushaltseinkommen: 37 % bis 50’000 CHF, 63 % über 50’000 CHF

Ergebnisse

Im Folgenden werden alle Fragen und die jeweiligen Umfrageergebnisse genau erläutert.

Eine Interpretation der Ergebnisse befindet sich im danach folgenden Abschnitt.

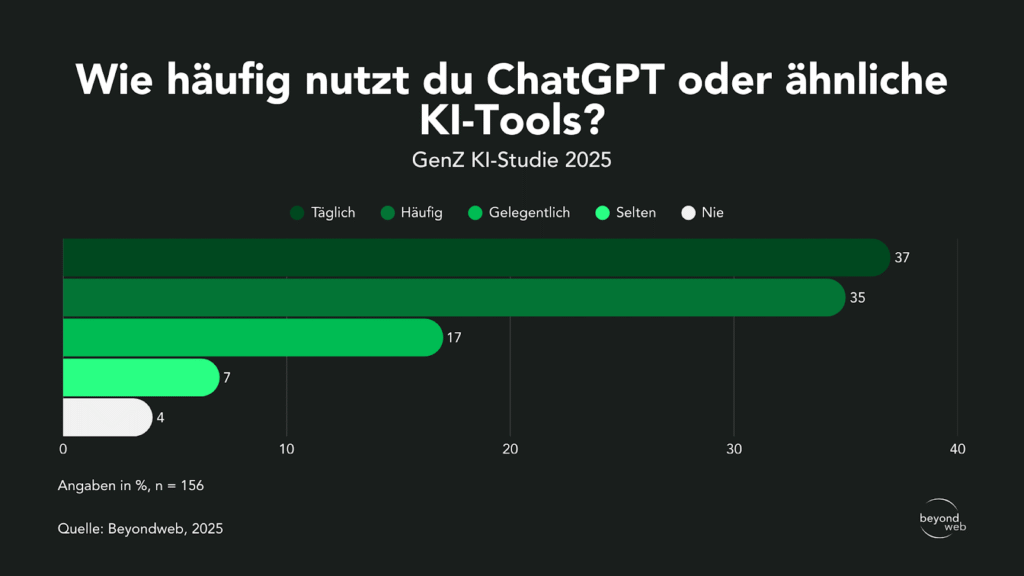

Häufigkeit der Nutzung von ChatGPT

Laut den Resultaten unserer Studie nutzen 37 % der Befragten ChatGPT täglich, 35 % verwenden das Tool häufig.

17 % greifen gelegentlich darauf zurück, 7 % nutzen es selten, und 4 % gaben an, es gar nicht zu verwenden.

Antworten aller Befragten auf die Frage “Wie häufig nutzt du ChatGPT oder ähnliche KI-Tools?“

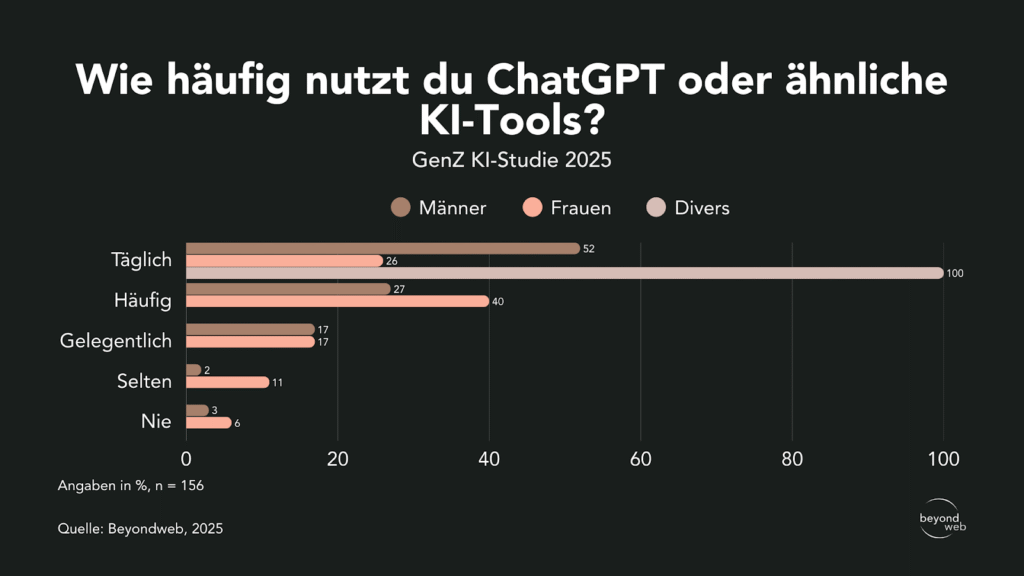

Nach Geschlecht zeigt sich, dass 52 % der Männer und 26 % der Frauen ChatGPT täglich nutzen.

Bei den divers-identifizierten Personen, die befragt wurden, sind es 100%.

Häufig nutzen es 40 % der Frauen und 27 % der Männer.

Gelegentlich greifen 17 % der Männer und 17 % der Frauen darauf zurück. Selten nutzen es 11 % der Frauen und 2 % der Männer.

Nie genutzt haben es 3 % der Männer und 6 % der Frauen.

Antworten unterteilt nach dem Geschlecht auf die Frage “Wie häufig nutzt du ChatGPT oder ähnliche KI-Tools?”

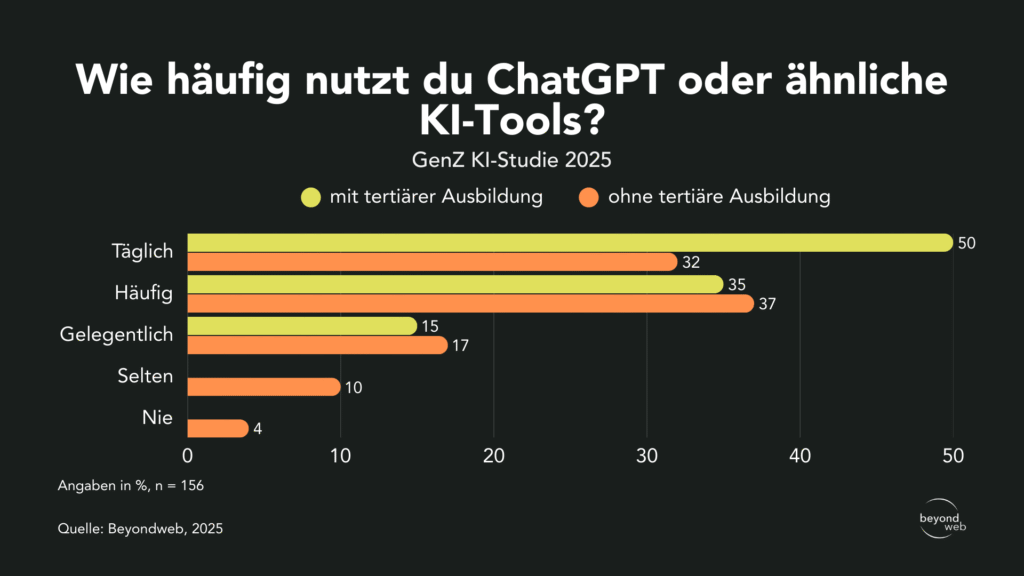

50 % der Akademiker:innen geben an, das Tool täglich zu verwenden, während dieser Anteil bei Personen ohne tertiäre Ausbildung bei 32 % liegt.

35 % der Befragten mit Universitäts- oder Fachhochschulabschluss nutzen ChatGPT häufig, im Vergleich zu 37 % der Befragten ohne tertiäre Bildung.

Gelegentlich wird das Tool von 15 % mit tertiärer Ausbildung und von 17 % ohne tertiäre Ausbildung verwendet.

Selten wird das Tool von 10 % ohne tertiäre Ausbildung genutzt, während keiner der Befragten mit tertiärer Ausbildung es nur gelegentlich verwendet.

Keiner der Befragten mit akademischem Abschluss hat ChatGPT noch nie genutzt, während 4 % der Befragten ohne höhere Bildung angeben, das Tool noch nie verwendet zu haben.

Antworten unterteilt nach dem Bildungsstand auf die Frage “Wie häufig nutzt du ChatGPT oder ähnliche KI-Tools?”

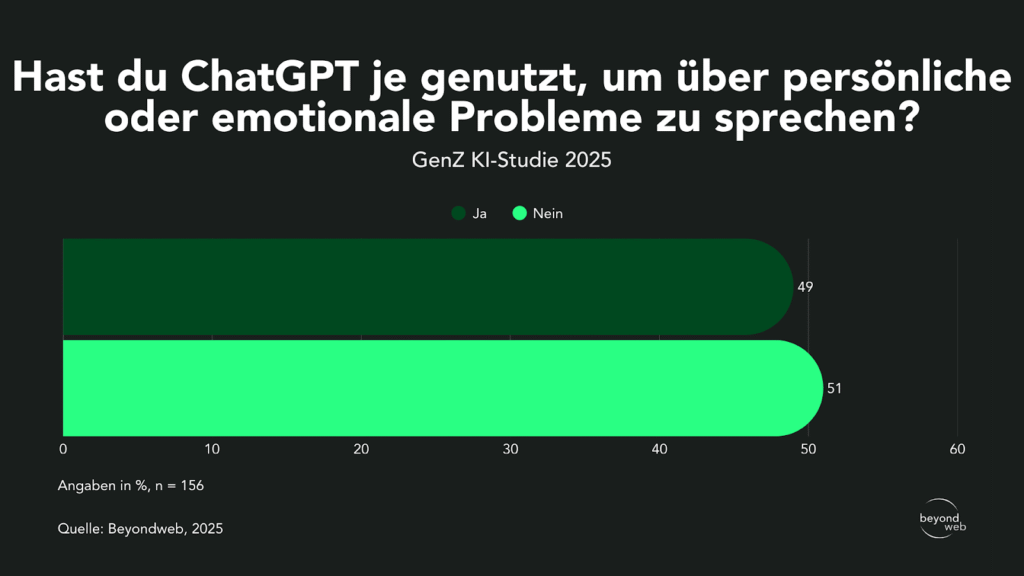

Nutzung von ChatGPT im psychischen/mentalen Kontext

Laut unseren Studienresultaten haben 49 % der Befragten ChatGPT bereits genutzt, um über persönliche oder emotionale Probleme zu sprechen.

51 % gaben an, dies noch nie getan zu haben.

Antworten aller Befragten auf die Frage “Hast du ChatGPT je genutzt, um über persönliche oder emotionale Probleme zu sprechen?“

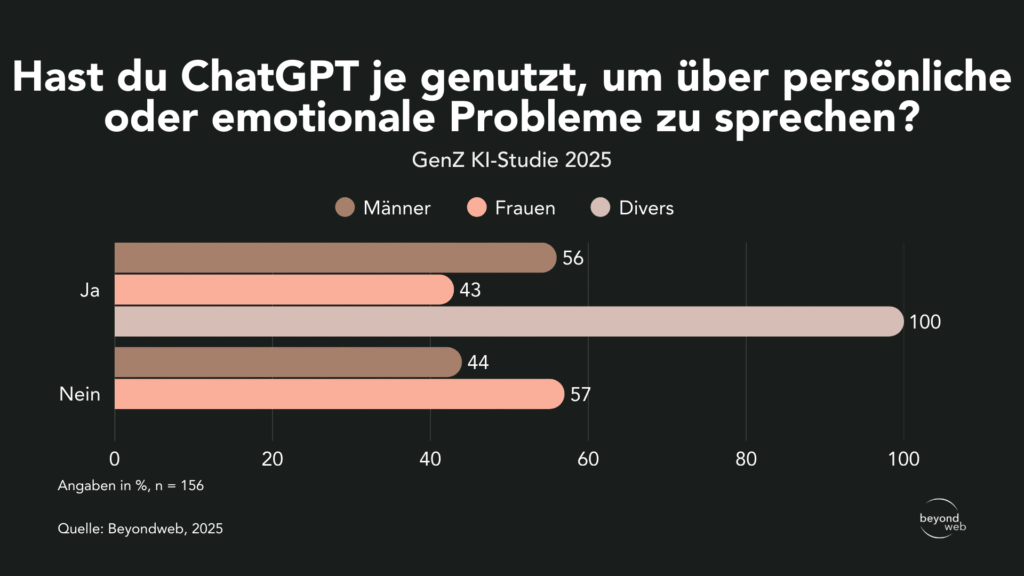

Nach Geschlecht zeigt sich, dass 56 % der Männer (blau) und 43 % der Frauen (grün) ChatGPT bereits für persönliche oder emotionale Anliegen genutzt haben.

Nicht genutzt haben ChatGPT in diesem Zusammenhang 44 % der Männer und 57 % der Frauen.

Unter den divers-identifizierten Personen gab niemand an, ChatGPT noch nie für Gespräche über persönliche oder emotionale Anliegen verwendet zu haben.

Antworten unterteilt nach dem Geschlecht auf die Frage “Hast du ChatGPT je genutzt, um über persönliche oder emotionale Probleme zu sprechen?”

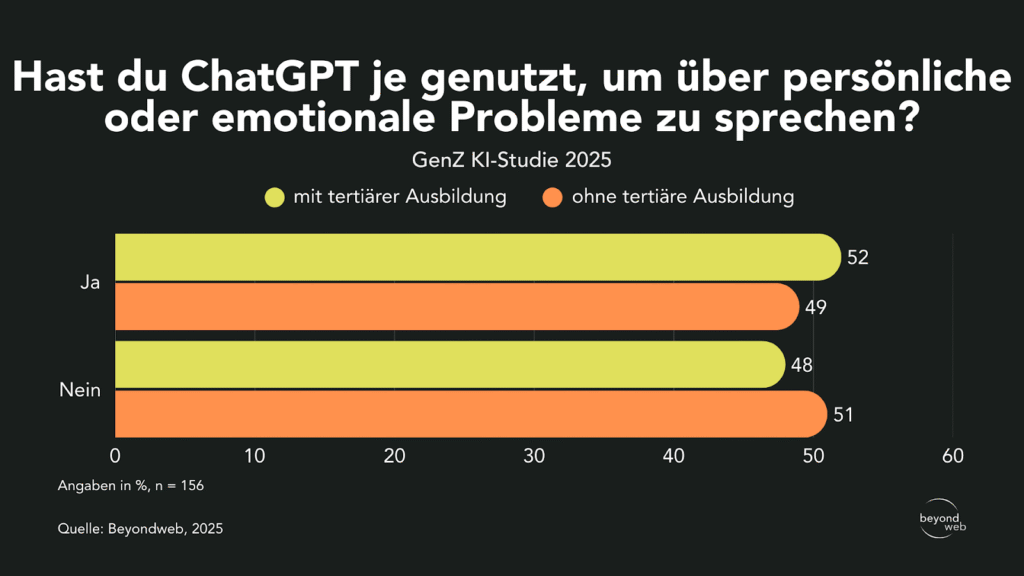

Unterteilt nach Ausbildung haben 52 % der Personen mit tertiärem Abschluss ChatGPT bereits für persönliche oder emotionale Probleme genutzt, bei den Befragten ohne tertiäre Ausbildung sind es 49 %.

Nicht genutzt haben ChatGPT zu diesem Zweck 48 % der Akademiker:innen und 51 % der Befragten ohne höheren Bildungsabschluss.

Antworten unterteilt nach dem Bildungsstand auf die Frage “Hast du ChatGPT je genutzt, um über persönliche oder emotionale Probleme zu sprechen?”

Verwendungszwecke von ChatGPT im psychischen Bereich

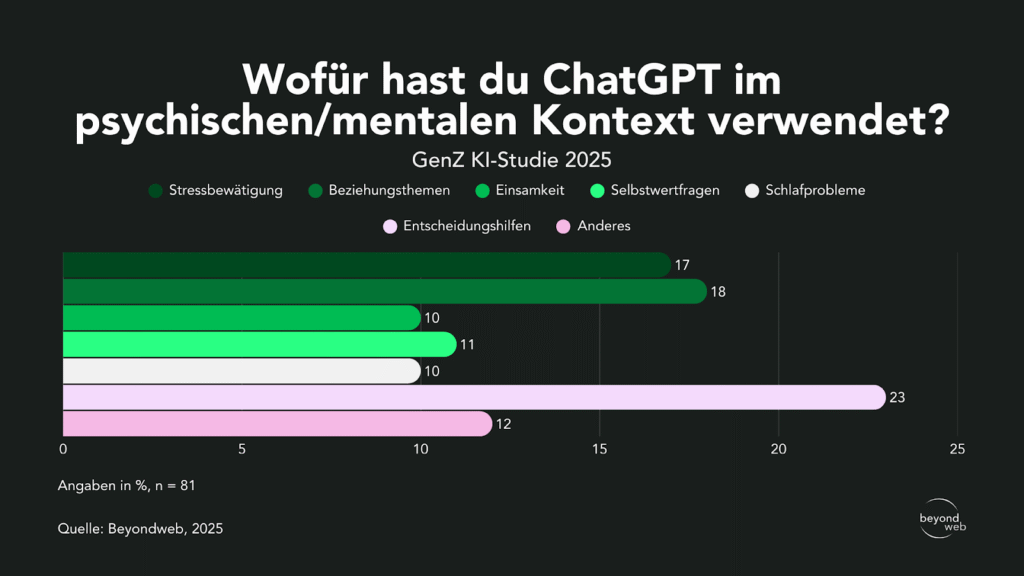

Im persönlich-beratenden Kontext nutzen die Befragten ChatGPT für verschiedene Zwecke.

Am häufigsten genannt wurde Entscheidungshilfe mit 23 %, gefolgt von Beziehungsthemen (18 %) und Stressbewältigung (17 %).

11 % nannten Selbstwertfragen, während 10 % ChatGPT für Schlafprobleme oder Einsamkeit nutzten.

Unter „Anderes“ gaben 12 % weitere Themen an.

Antworten aller Befragten auf die Frage “Wofür hast du ChatGPT im psychischen/mentalen Kontext verwendet?“

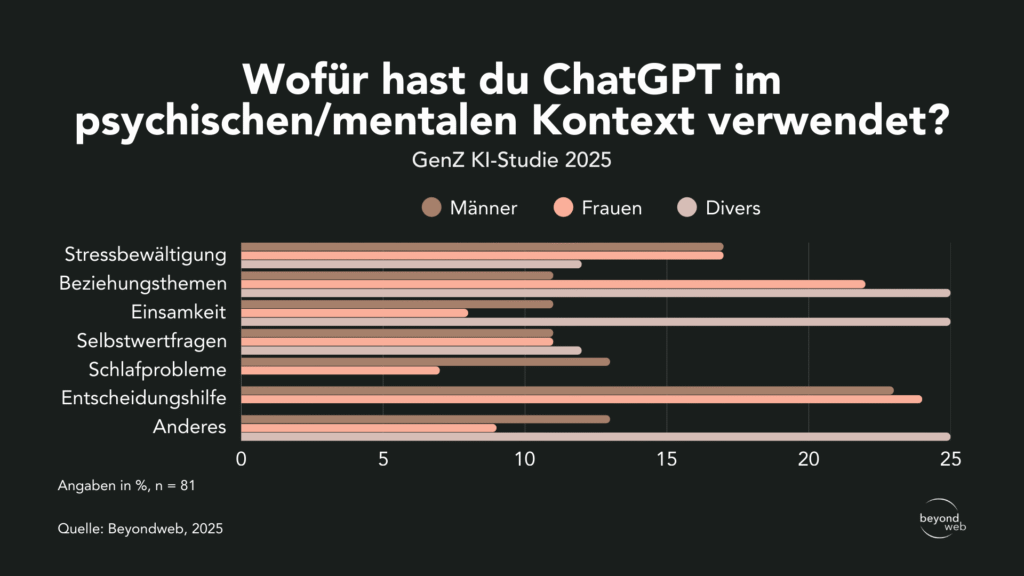

Nach Geschlecht zeigt sich ein differenziertes Bild:

- Stressbewältigung: 17 % der Männer, 17 % der Frauen und 12 % der divers-identifizierten Personen.

- Beziehungsthemen: 11 % der Männer, 22 % der Frauen und 25 % der divers-identifizierten Personen.

- Einsamkeit: 11 % der Männer, 8 % der Frauen und 25 % der divers-identifizierten Personen.

- Selbstvertrauen: 11 % der Männer, 11 % der Frauen und 12 % der divers-identifizierten Personen.

- Schlafprobleme: 13 % der Männer, 7 % der Frauen und 0 % der divers-identifizierten Personen.

- Entscheidungshilfe: 23 % der Männer, 24 % der Frauen und 0 % der divers-identifizierten Personen.

- Anderes: 13 % der Männer, 9 % der Frauen und 25 % der divers-identifizierten Personen.

Antworten unterteilt nach dem Geschlecht auf die Frage “Wofür hast du ChatGPT im psychischen/mentalen Kontext verwendet?”

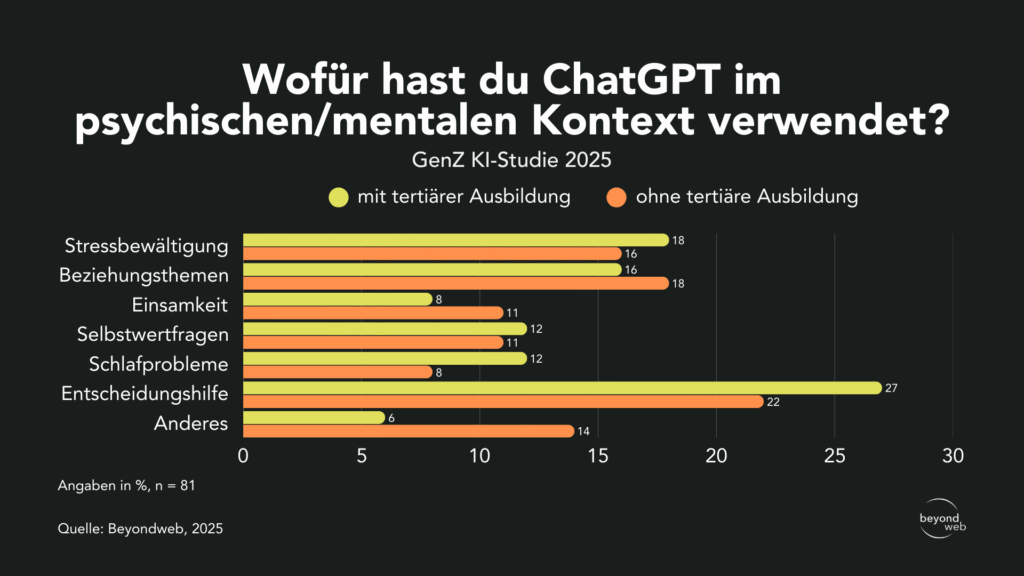

Auch nach Ausbildungsstand zeigen sich Unterschiede:

- Stressbewältigung: 18 % der Befragten mit tertiärer Ausbildung und 16 % ohne tertiären Abschluss.

- Beziehungsthemen: 16 % der Akademiker:innen und 18 % der Nicht-akademiker:innen.

- Einsamkeit: 8 % der Personen mit tertiärer Ausbildung und 11 % ohne tertiäre Ausbildung.

- Selbstvertrauen: 12 % mit tertiärer Ausbildung und 11 % ohne tertiäre Ausbildung.

- Schlafprobleme: 12 % der Akademiker:innen und 8 % der Nicht-akademiker:innen.

- Entscheidungshilfe: 27 % mit tertiärem Abschluss und 22 % ohne.

- Anderes: 6 % der Akademiker:innen und 14 % der Nicht-akademiker:innen.

Antworten unterteilt nach dem Bildungsstand auf die Frage “Wofür hast du ChatGPT im psychischen/mentalen Kontext verwendet?“

Einschätzung der Nützlichkeit von ChatGPT-Antworten

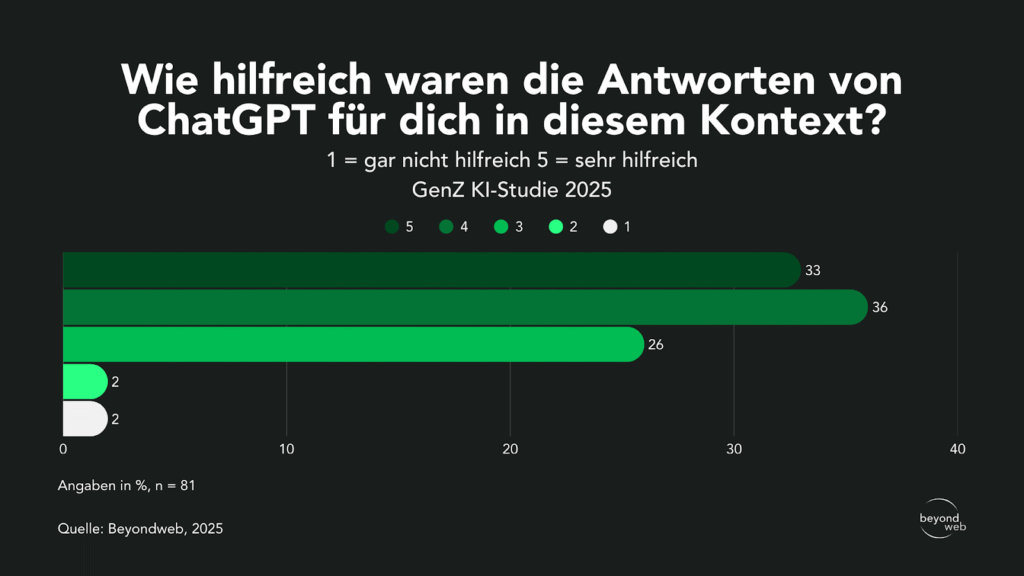

Laut unseren Studienresultaten empfanden 36 % der Befragten die Antworten von ChatGPT als 4 = hilfreich, während 33 % sie mit 5 = sehr hilfreich bewerteten.

26 % vergaben die Note 3 = teils/teils. Nur 2 % stuften die Antworten mit 1 = gar nicht hilfreich ein, und weitere 2 % mit 2 = wenig hilfreich.

Antworten aller Befragten auf die Frage “Wie hilfreich waren die Antworten von ChatGPT für dich in diesem Kontext? (1 = gar nicht hilfreich 5 = sehr hilfreich)”

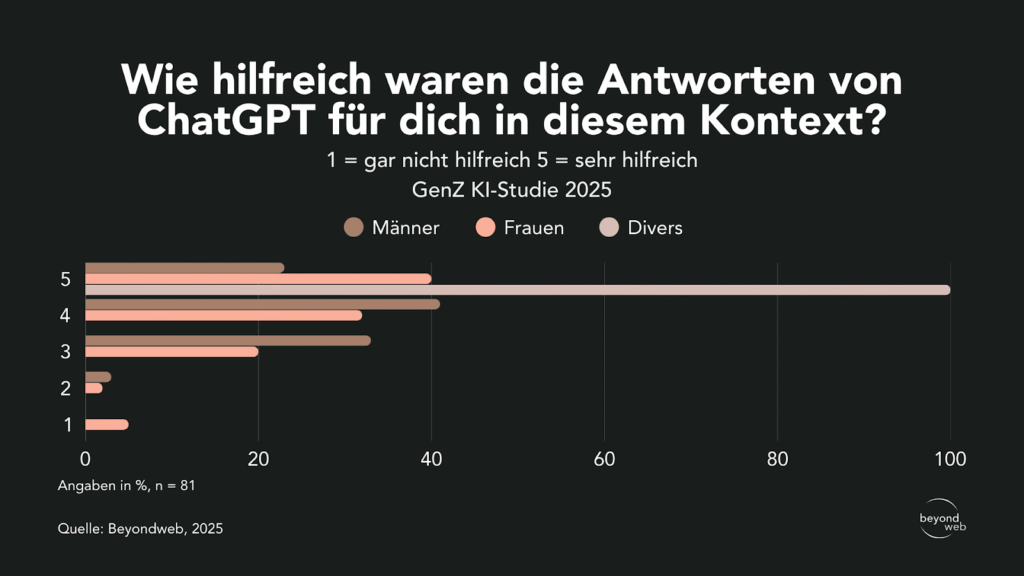

Nach Geschlecht zeigt sich, dass 41 % der Männer die Antworten mit 4 bewertet haben, während es bei den Frauen 32 % waren.

Die Höchstbewertung 5 gaben 23 % der Männer und 40 % der Frauen.

Bei den divers-identifizierten Personen vergaben 100 % die Höchstnote 5.

Die mittlere Bewertung 3 vergaben 33 % der Männer und 20 % der Frauen.

Mit 2 bewerteten 3 % der Männer und 2 % der Frauen.

Die niedrigste Bewertung 1 gaben 5 % der Frauen, während kein Mann und keine divers-identifizierte Person diese Option wählte.

Antworten unterteilt nach dem Geschlecht auf die Frage “Wie hilfreich waren die Antworten von ChatGPT für dich in diesem Kontext? (1 = gar nicht hilfreich 5 = sehr hilfreich)”

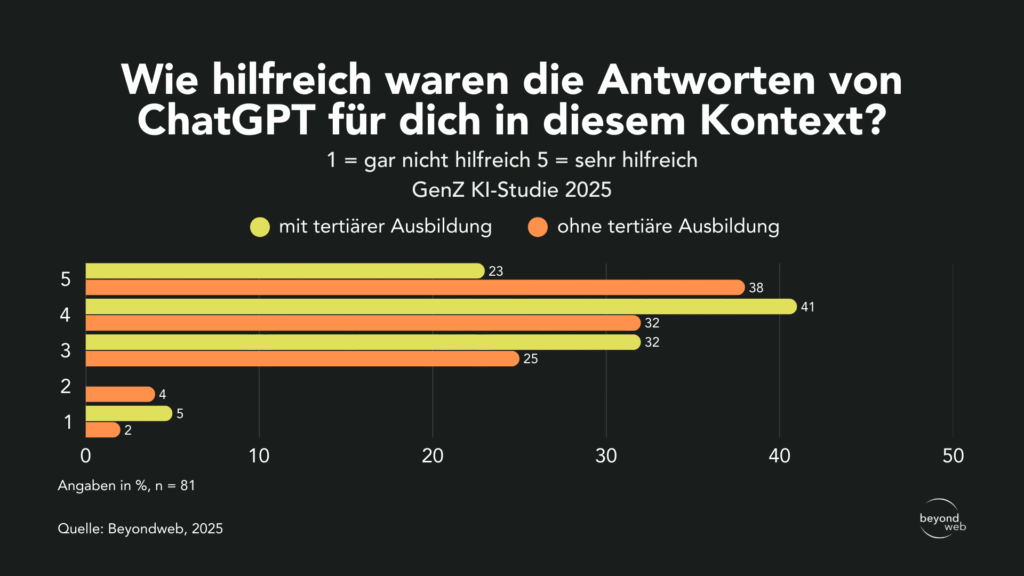

Unterteilt nach Bildungsstand zeigt sich, dass 41 % der Befragten mit tertiärer Ausbildung die Antworten von ChatGPT mit 4 bewerteten, während es bei den Nicht-akademiker:innen 32 % waren.

Die Höchstbewertung 5 gaben 38 % der Personen ohne tertiären Abschluss und 23 % der Befragten mit tertiärer Ausbildung.

Die mittlere Bewertung 3 vergaben 32 % der Akademiker:innen und 25 % der Nicht-akademiker:innen.

Mit 2 bewerteten 4 % der Personen ohne tertiäre Ausbildung und keine Person mit tertiärer Ausbildung.

Die niedrigste Bewertung 1 gaben 5 % der Akademiker:innen und 2 % ohne tertiäre Ausbildung.

Antworten unterteilt nach dem Bildungsstand auf die Frage “Wie hilfreich waren die Antworten von ChatGPT für dich in diesem Kontext? (1 = gar nicht hilfreich 5 = sehr hilfreich)”

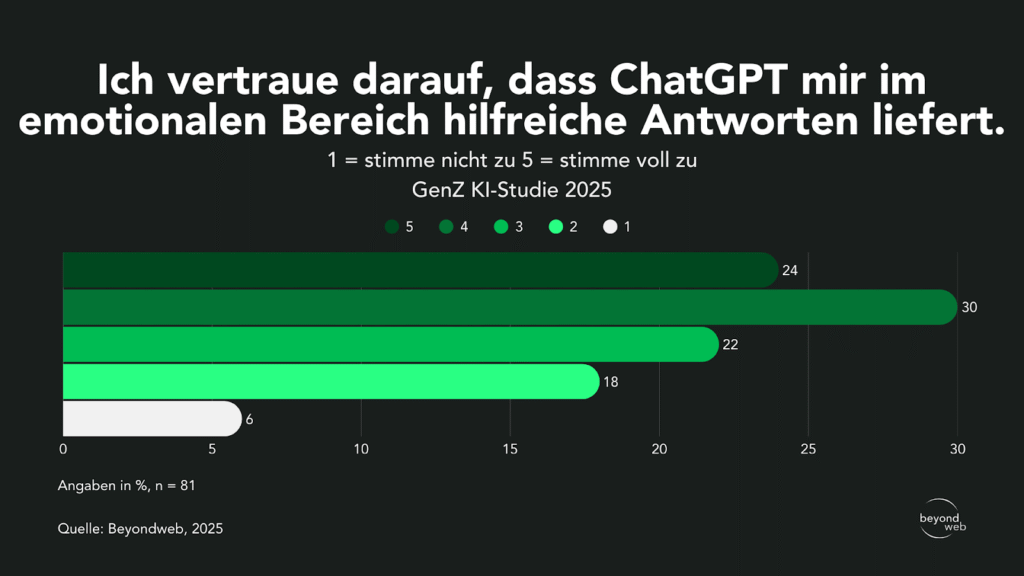

Vertrauen in die Hilfestellung von ChatGPT

Laut unseren Studienresultaten vertrauen 30 % der Befragten darauf, dass ChatGPT im emotionalen Bereich hilfreiche Antworten liefert (4), und 24 % stimmen dem sogar voll zu (5).

22 % äusserten eine mittlere Zustimmung (3).

Weniger Vertrauen zeigen 18 % mit einer Bewertung von 2, während 6 % angaben, dem überhaupt nicht zuzustimmen (1).

Antworten aller Befragten auf die Frage “Ich vertraue darauf, dass ChatGPT mir im emotionalen Bereich hilfreiche Antworten liefert. (1 = stimme nicht zu 5 = stimme voll zu)”

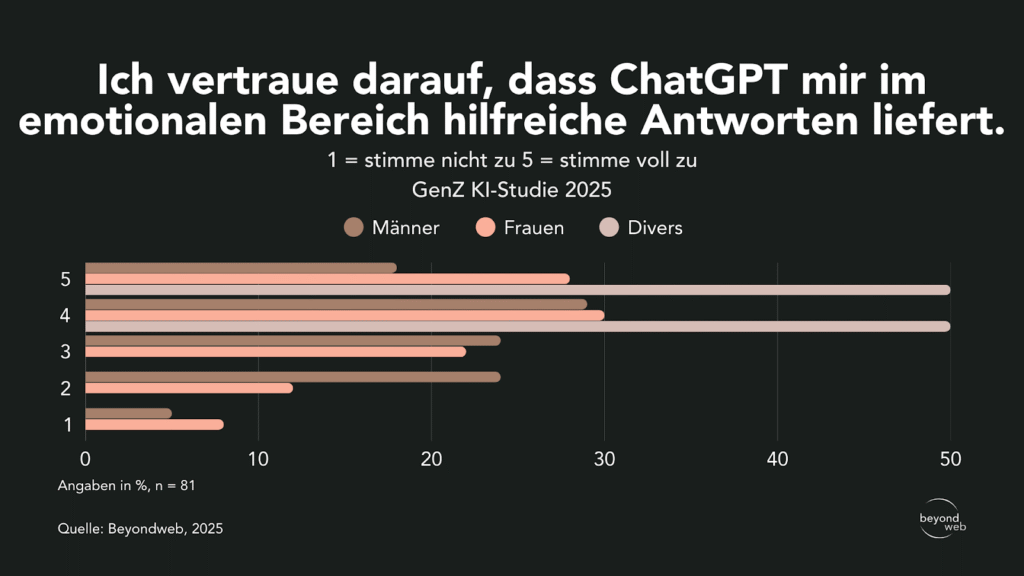

Nach Geschlecht zeigt sich, dass 29 % der Männer, 30 % der Frauen und 50 % der divers-identifizierten Personen mit 4 antworteten.

Die Höchstbewertung 5 gaben 18 % der Männer, 28 % der Frauen und 50 % der divers-identifizierten Personen.

Mit 3 bewerteten 24 % der Männer und 22 % der Frauen.

Die Bewertung 2 gaben 24 % der Männer und 12 % der Frauen.

Die niedrigste Bewertung 1 gaben 5 % der Männer und 8 % der Frauen.

Antworten unterteilt nach dem Geschlecht auf die Frage “Ich vertraue darauf, dass ChatGPT mir im emotionalen Bereich hilfreiche Antworten liefert. (1 = stimme nicht zu 5 = stimme voll zu)”

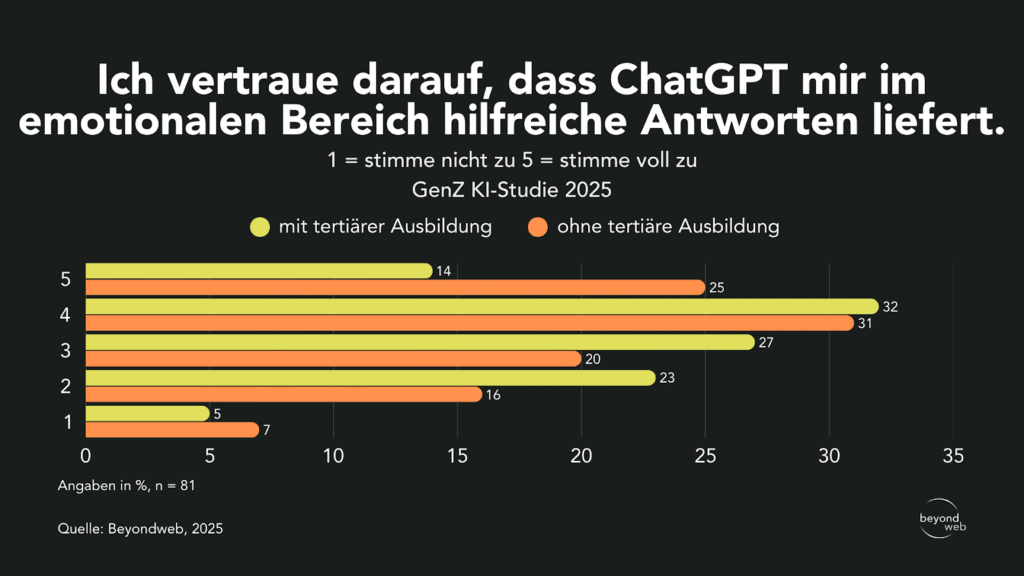

Unterteilt nach Ausbildung zeigen sich folgende Unterschiede: 32 % der Befragten mit tertiärer Ausbildung und 31 % ohne höheren Abschluss vergaben die Bewertung 4.

Mit 5 stimmten 14 % der Akademiker:innen und 25 % der Nicht-akademiker:innen voll zu.

Die mittlere Bewertung 3 vergaben 27 % mit tertiärer Ausbildung und 20 % ohne.

Mit 2 bewerteten 23 % der Akademiker:innen und 16 % der Nicht-akademiker:innen.

Die niedrigste Bewertung 1 gaben 5 % der Personen mit tertiärem Abschluss und 7 % ohne.

Antworten unterteilt nach dem Bildungsstand auf die Frage “Ich vertraue darauf, dass ChatGPT mir im emotionalen Bereich hilfreiche Antworten liefert. (1 = stimme nicht zu 5 = stimme voll zu)”

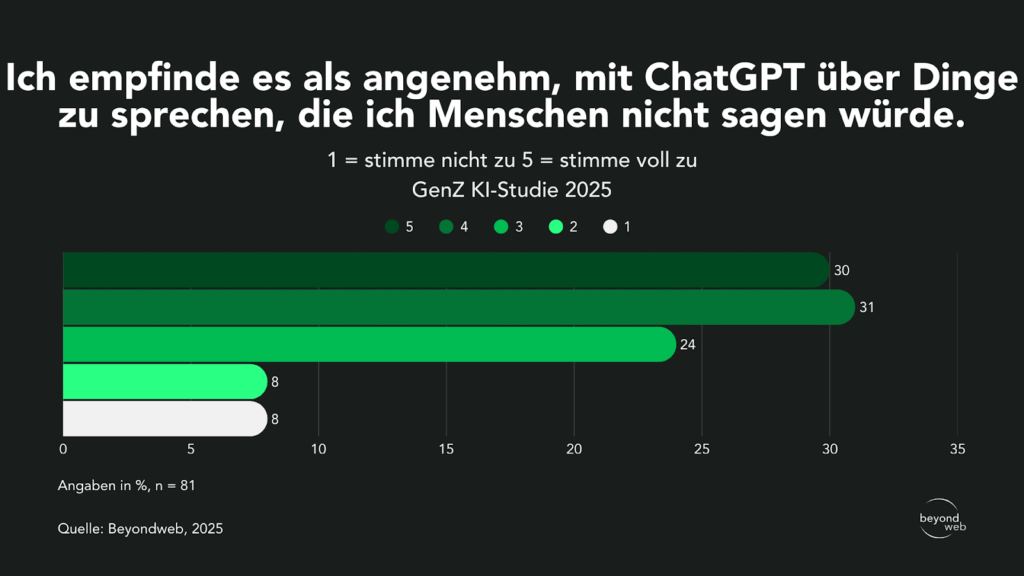

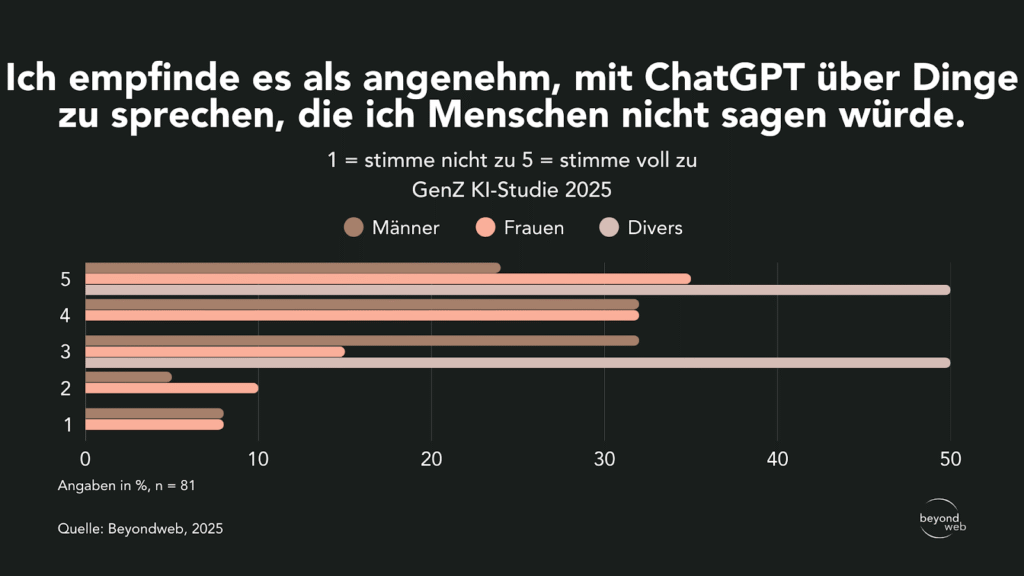

Empfundene Anonymität bei der Kommunikation mit ChatGPT

31 % der Befragten empfinden es als angenehm (Wert 4), mit ChatGPT über Dinge zu sprechen, die sie Menschen nicht sagen würden.

30 % stimmen dieser Aussage sogar voll zu (5).

24 % äusserten eine mittlere Zustimmung (3).

Nur 8 % gaben an, der Aussage überhaupt nicht zuzustimmen (1) und weitere 8 % stimmten nur wenig zu (2).

Antworten aller Befragten auf die Frage “Ich empfinde es als angenehm, mit ChatGPT über Dinge zu sprechen, die ich Menschen nicht sagen würde. (1 = stimme nicht zu 5 = stimme voll zu)”

Im Geschlechtervergleich bewerteten 32 % der Männer und 32 % der Frauen die Aussage mit 4.

Mit 5 stimmten 24 % der Männer, 35 % der Frauen und 50 % der divers-identifizierten Personen voll zu.

Die mittlere Bewertung 3 vergaben 32 % der Männer, 15 % der Frauen und 50 % der divers-identifizierten Personen.

Mit 2 bewerteten 5 % der Männer und 10 % der Frauen.

Die niedrigste Bewertung 1 gaben 8 % der Männer und 8 % der Frauen; keine divers-identifizierte Person wählte diese Option.

Antworten unterteilt nach dem Geschlecht auf die Frage “Ich empfinde es als angenehm, mit ChatGPT über Dinge zu sprechen, die ich Menschen nicht sagen würde. (1 = stimme nicht zu 5 = stimme voll zu)”

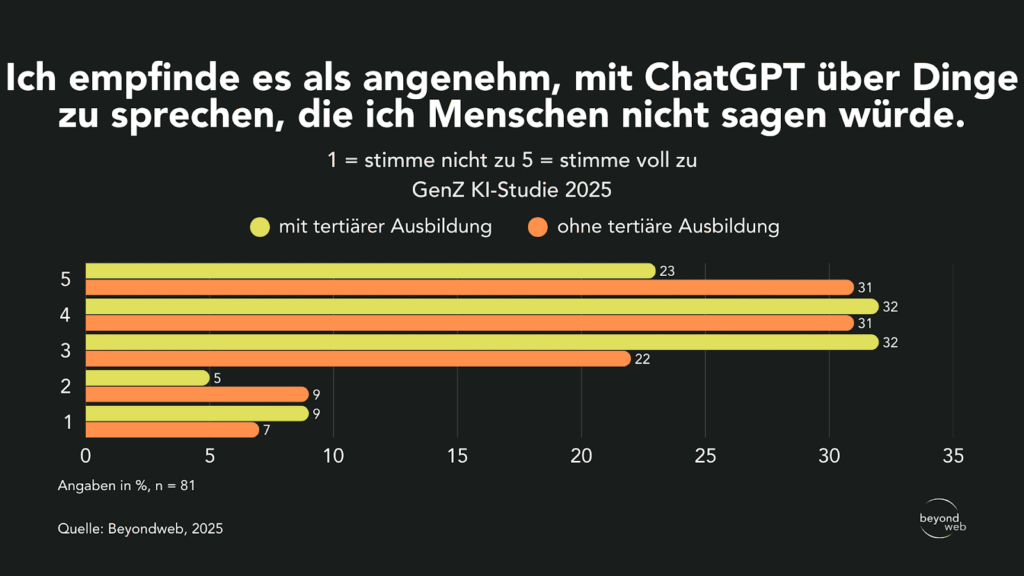

Unterteilt nach Ausbildung zeigt sich, dass 32 % der Befragten mit tertiärem Abschluss und 22 % ohne höheren Abschluss die Aussage mit 3 bewerteten.

Mit 4 stimmten 32 % der Akademiker:innen und 31 % der Nicht-akademiker:innen zu.

Die Höchstbewertung 5 vergaben 23 % der Personen mit tertiärer Ausbildung und 31 % der Personen ohne tertiären Abschluss.

Mit 2 bewerteten 5 % der Akademiker:innen und 9 % der Nicht-akademiker:innen.

Die niedrigste Bewertung 1 gaben 9 % der Personen mit tertiärer Ausbildung und 7 % der Personen ohne.

Antworten unterteilt nach dem Bildungsstand auf die Frage “Ich empfinde es als angenehm, mit ChatGPT über Dinge zu sprechen, die ich Menschen nicht sagen würde. (1 = stimme nicht zu 5 = stimme voll zu)”

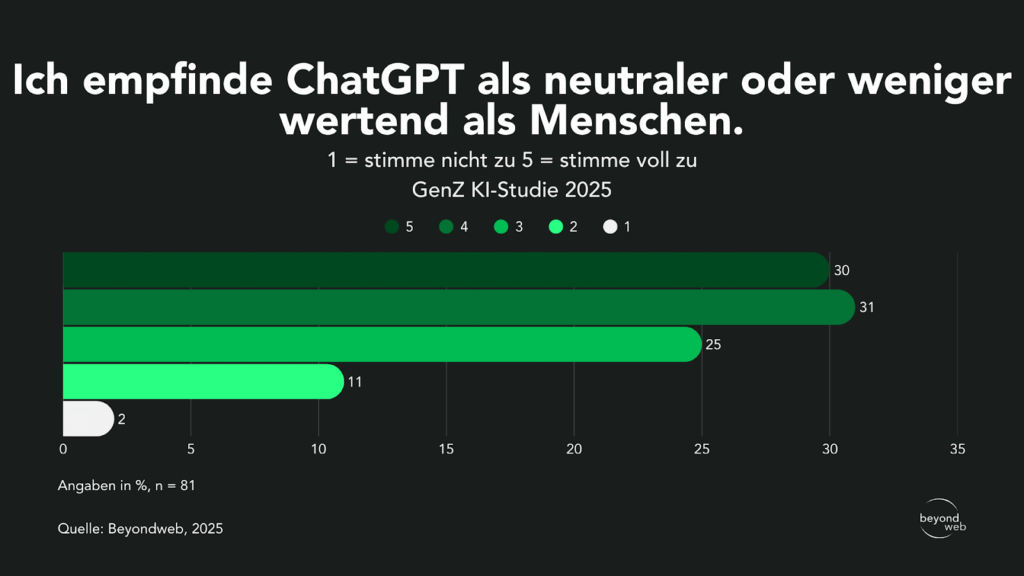

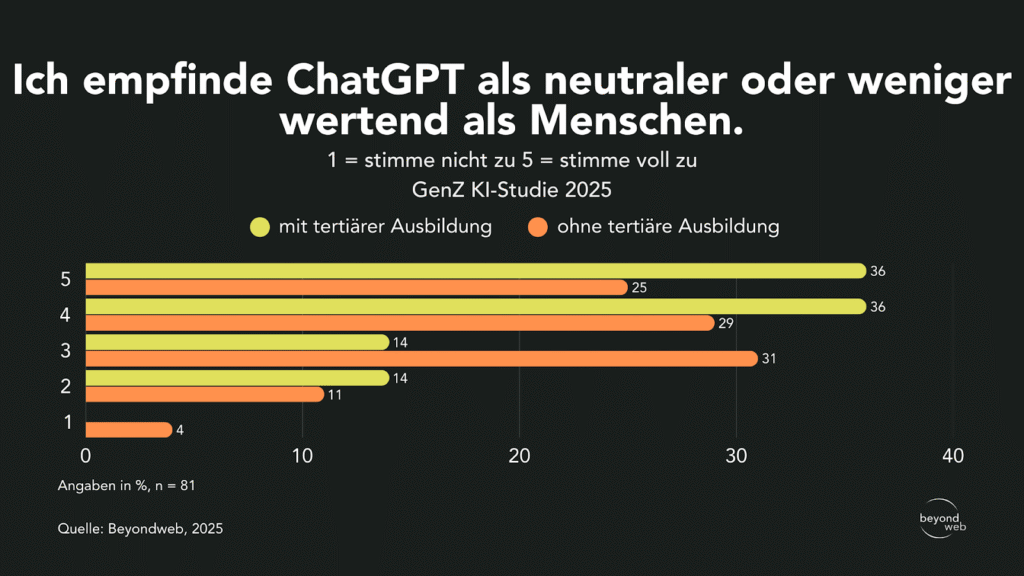

Wahrgenommene Neutralität von ChatGPT im Vergleich zu Menschen

31 % der Befragten empfinden ChatGPT als neutraler oder weniger wertend und vergaben hierfür den Wert 4.

30 % stimmten dieser Aussage voll zu (5).

25 % äusserten eine mittlere Zustimmung (3).

Geringere Zustimmung zeigten 11 % mit dem Wert 2, während nur 2 % der Befragten angaben, überhaupt nicht zuzustimmen (1).

Antworten aller Befragten auf die Frage “Ich empfinde ChatGPT als neutraler oder weniger wertend als Menschen. (1 = stimme nicht zu 5 = stimme voll zu)”

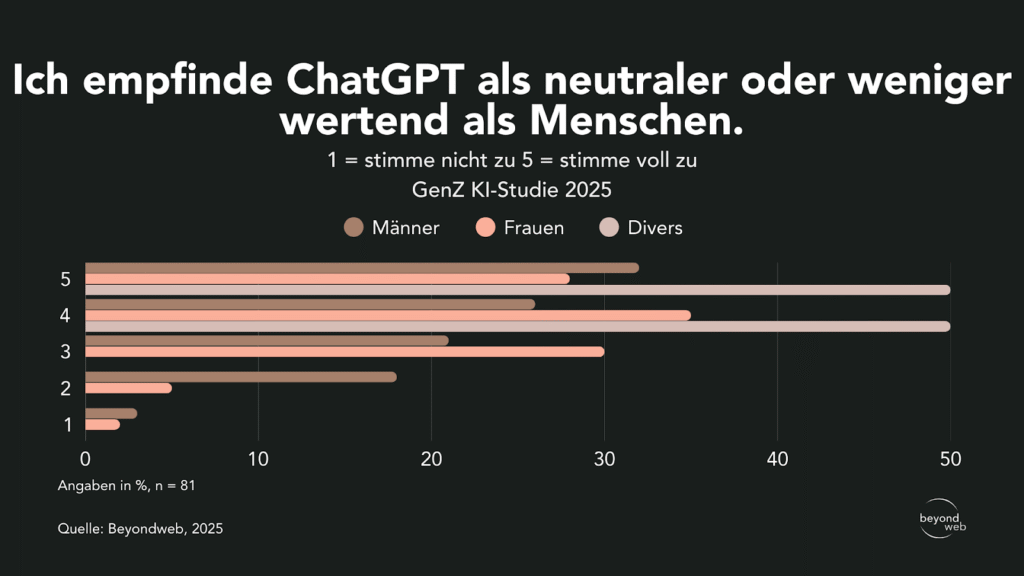

Nach Geschlecht zeigt sich, dass 26 % der Männer, 35 % der Frauen, sowie 50 % der divers-identifizierten Personen die Aussage mit 4 bewerteten.

Die Höchstbewertung 5 gaben 32 % der Männer, 28 % der Frauen sowie 50 % der divers-identifizierten Personen.

Die mittlere Zustimmung 3 vergaben 21 % der Männer und 30 % der Frauen.

Mit 2 bewerteten 18 % der Männer und 5 % der Frauen.

Die niedrigste Bewertung 1 gaben 3 % der Männer und 2 % der Frauen; keine divers-identifizierte Person wählte diese Option.

Antworten unterteilt nach dem Geschlecht auf die Frage “Ich empfinde ChatGPT als neutraler oder weniger wertend als Menschen. (1 = stimme nicht zu 5 = stimme voll zu)”

Unterteilt nach Ausbildung zeigt sich, dass 36 % der Befragten mit tertiärem Abschluss und 29 % ohne höheren Abschluss die Aussage mit 4 bewerteten.

Mit 5 stimmten 36 % der Akademiker:innen und 25 % der Nicht-akademiker:innen voll zu.

Die mittlere Zustimmung 3 vergaben 14 % der Personen mit tertiärem Abschluss und 31 % der Befragten ohne.

Mit 2 bewerteten 14 % der Akademiker:innen und 11 % der Nicht-akademiker:innen.

Die niedrigste Zustimmung 1 gaben 4 % der Befragten ohne tertiäre Ausbildung; bei den Personen mit tertiärer Ausbildung wurde dieser Wert nicht genannt.

Antworten unterteilt nach dem Bildungsstand auf die Frage “Ich empfinde ChatGPT als neutraler oder weniger wertend als Menschen. (1 = stimme nicht zu 5 = stimme voll zu)”

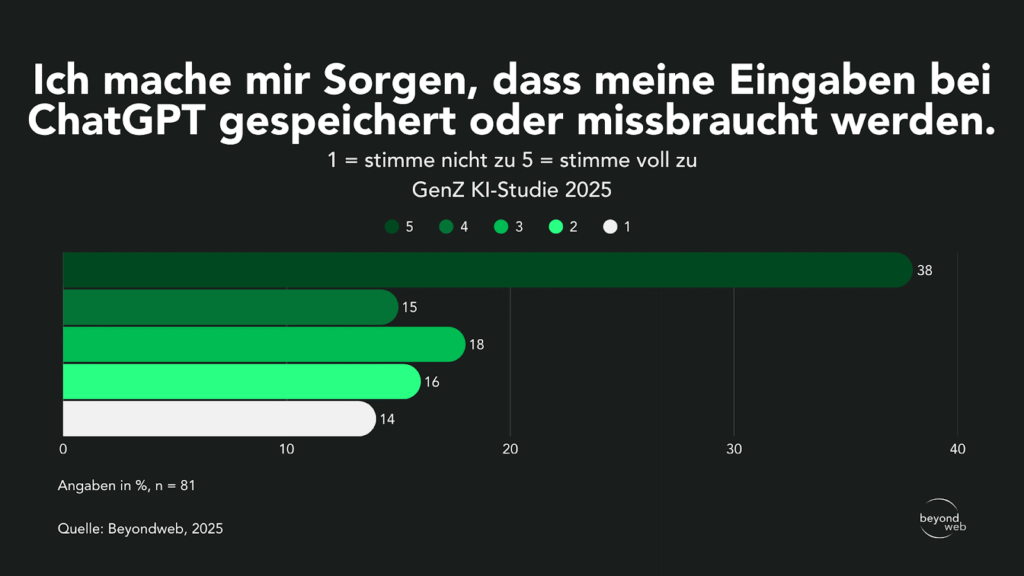

Einschätzung von Datenschutzbedenken bei der Nutzung von ChatGPT

Laut unseren Studienresultaten machen sich 38 % der Befragten grosse Sorgen darüber, dass ihre Eingaben bei ChatGPT gespeichert oder missbraucht werden könnten (5 = stimme voll zu).

15 % bewerteten mit 4 und machen sich eher grosse Sorgen.

18 % äusserten mittlere Sorgen (3), 16 % gaben eine geringe Zustimmung (2), und nur 14 % der Befragten machen sich keinerlei Sorgen (1).

Antworten aller Befragten auf die Frage “Ich mache mir Sorgen, dass meine Eingaben bei ChatGPT gespeichert oder missbraucht werden. (1 = stimme nicht zu 5 = stimme voll zu)”

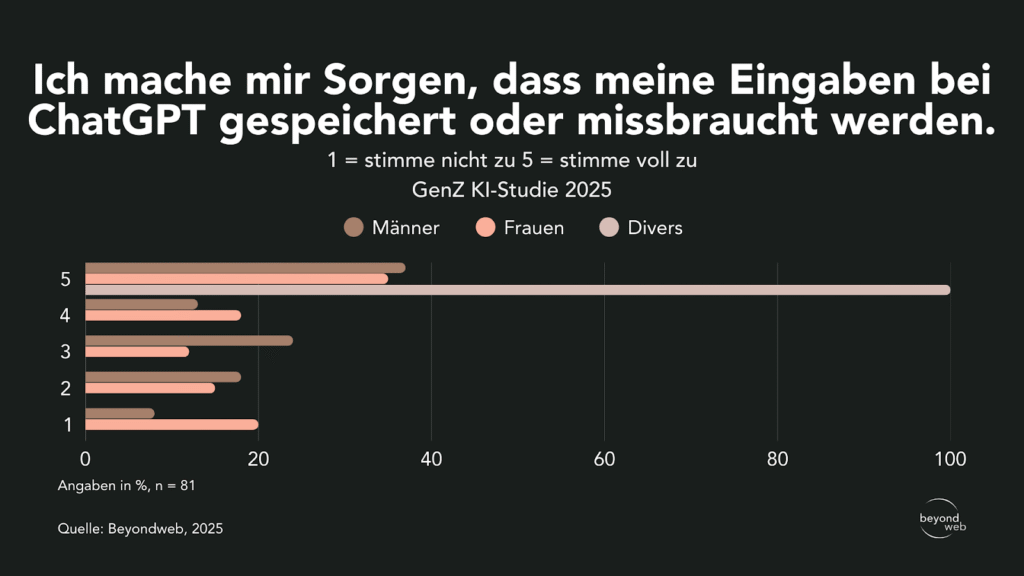

Nach Geschlecht zeigt sich, dass 37 % der Männer und 35 % der Frauen mit 5 antworteten.

Bei den divers-identifizierten Personen liegt dieser Anteil bei 100 %.

Mit 4 bewerteten 13 % der Männer und 18 % der Frauen.

3 wählten 24 % der Männer und 12 % der Frauen.

Eine geringe Zustimmung (2) gaben 18 % der Männer und 15 % der Frauen.

Ganz ohne Sorgen (1) waren 8 % der Männer und 20 % der Frauen.

Antworten unterteilt nach dem Geschlecht auf die Frage “Ich mache mir Sorgen, dass meine Eingaben bei ChatGPT gespeichert oder missbraucht werden. (1 = stimme nicht zu 5 = stimme voll zu)”

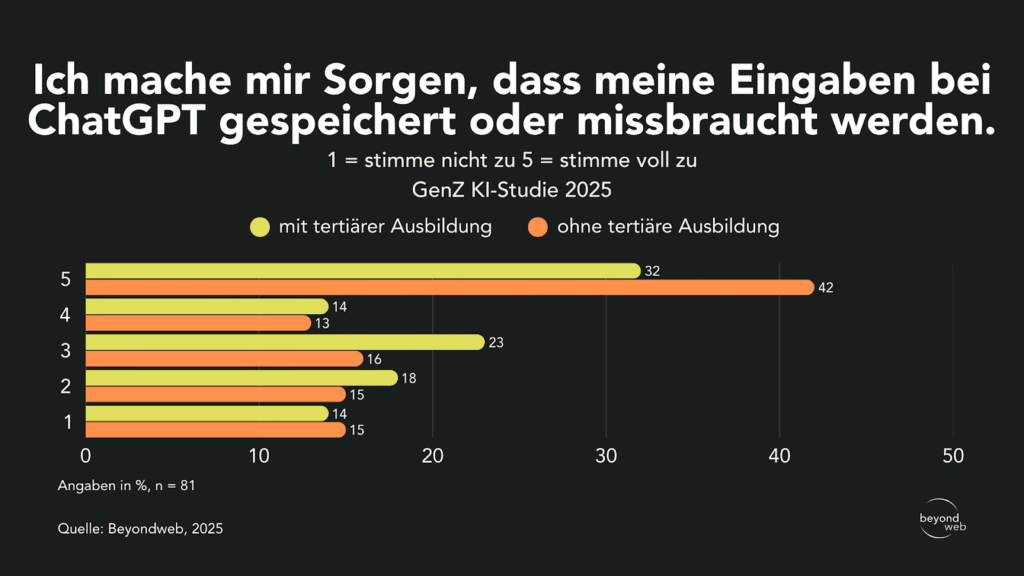

Unterteilt nach Ausbildung zeigen sich Unterschiede: 42 % der Befragten ohne tertiären Abschluss und 32 % mit tertiärem Abschluss gaben an, sich grosse Sorgen zu machen (5).

Mit 4 bewerteten 14 % der Akademiker:innen und 13 % der Nicht-akademiker:innen.

3 wählten 23 % der Personen mit tertiärer Ausbildung und 16 % ohne.

Eine geringe Zustimmung (2) äusserten 18 % der Akademiker:innen und 15 % der Nicht-akademiker:innen.

Keine Sorgen (1) haben 14 % der Befragten mit tertiärer Ausbildung und 15 % ohne.

Antworten unterteilt nach dem Bildungsstand auf die Frage “Ich mache mir Sorgen, dass meine Eingaben bei ChatGPT gespeichert oder missbraucht werden. (1 = stimme nicht zu 5 = stimme voll zu)”

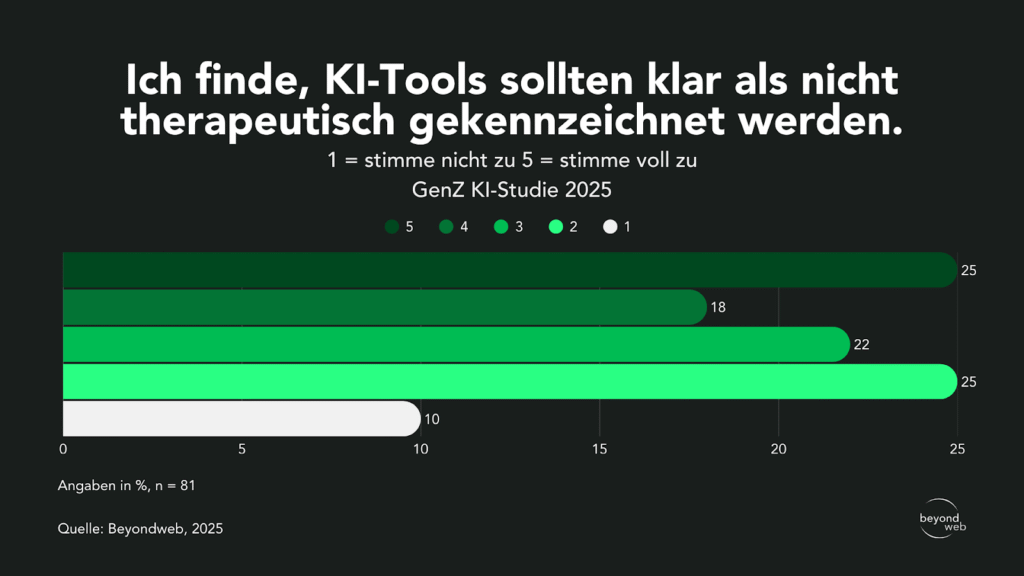

Einschätzung zur Kennzeichnung von KI-Tools als nicht therapeutisch

Laut unseren Studienresultaten sind 25 % der Befragten der Meinung, dass KI-Tools klar als nicht therapeutisch gekennzeichnet werden sollten und stimmten dem voll zu (5).

18 % stimmten eher zu (4) und 22 % äusserten eine mittlere Zustimmung (3).

25 % gaben an, eher nicht zuzustimmen (2).

Nur 10 % lehnten diese Aussage völlig ab (1).

Antworten aller Befragten auf die Frage “Ich finde, KI-Tools sollten klar als nicht therapeutisch gekennzeichnet werden. (1 = stimme nicht zu 5 = stimme voll zu)”

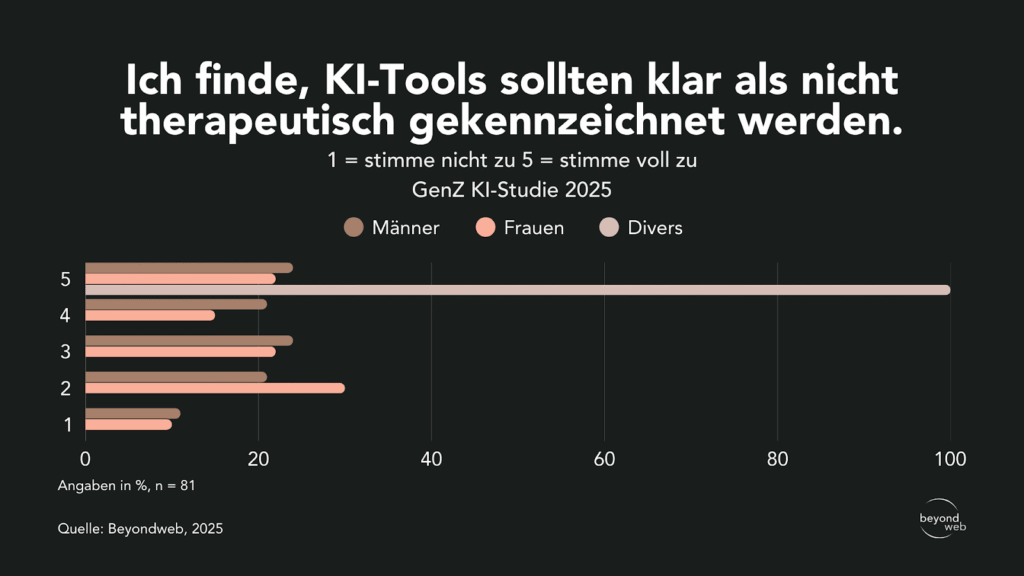

Nach Geschlecht zeigt sich, dass 24 % der Männer und 22 % der Frauen der Aussage voll zustimmen (5).

Bei den divers-identifizierten Personen liegt dieser Anteil bei 100 %.

Mit 4 stimmten 21 % der Männer und 15 % der Frauen eher zu.

3 wählten 24 % der Männer und 21 % der Frauen.

Eher nicht zugestimmt (2) haben 21 % der Männer und 30 % der Frauen.

Ganz abgelehnt (1) haben 11 % der Männer und 10 % der Frauen.

Antworten unterteilt nach dem Geschlecht auf die Frage “Ich finde, KI-Tools sollten klar als nicht therapeutisch gekennzeichnet werden. (1 = stimme nicht zu 5 = stimme voll zu)”

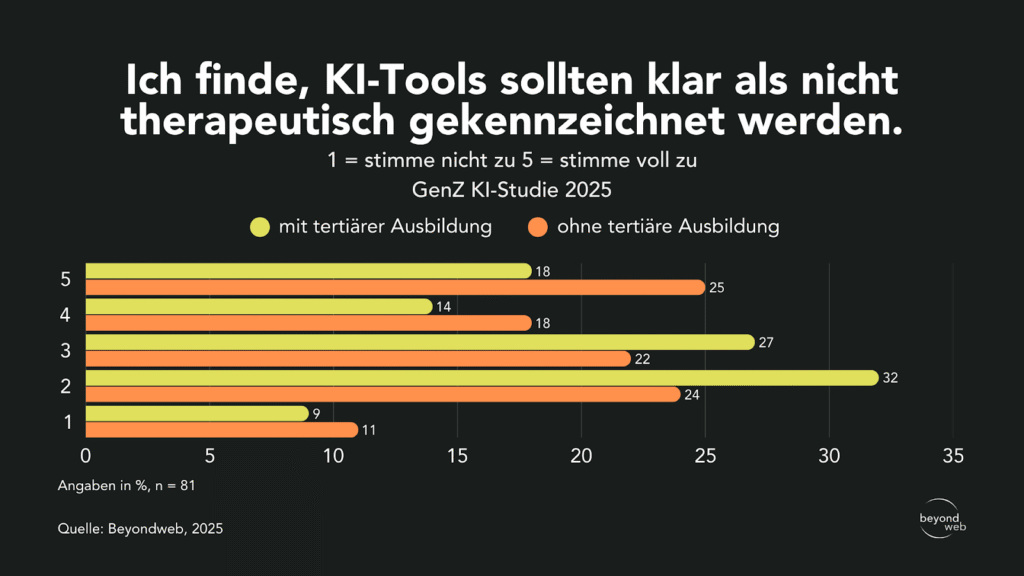

Unterteilt nach Ausbildung zeigt sich, dass 25 % der Befragten ohne tertiären Abschluss und 18 % mit tertiärem Abschluss der Aussage voll zustimmen (5).

Mit 4 bewerteten 18 % der Befragten ohne tertiären Abschluss und 14 % mit tertiärem Abschluss.

3 wählten 27 % der Personen mit tertiärer Ausbildung und 22 % ohne tertiären Abschluss.

Eher nicht zugestimmt (2) haben 32 % der Akademiker:innen und 24 % der Nicht-akademiker:innen.

Die Aussage völlig abgelehnt (1) haben 9 % der Akademiker:innen und 11 % der Befragten ohne höheren Abschluss.

Antworten unterteilt nach dem Bildungsstand auf die Frage “Ich finde, KI-Tools sollten klar als nicht therapeutisch gekennzeichnet werden. (1 = stimme nicht zu 5 = stimme voll zu)”

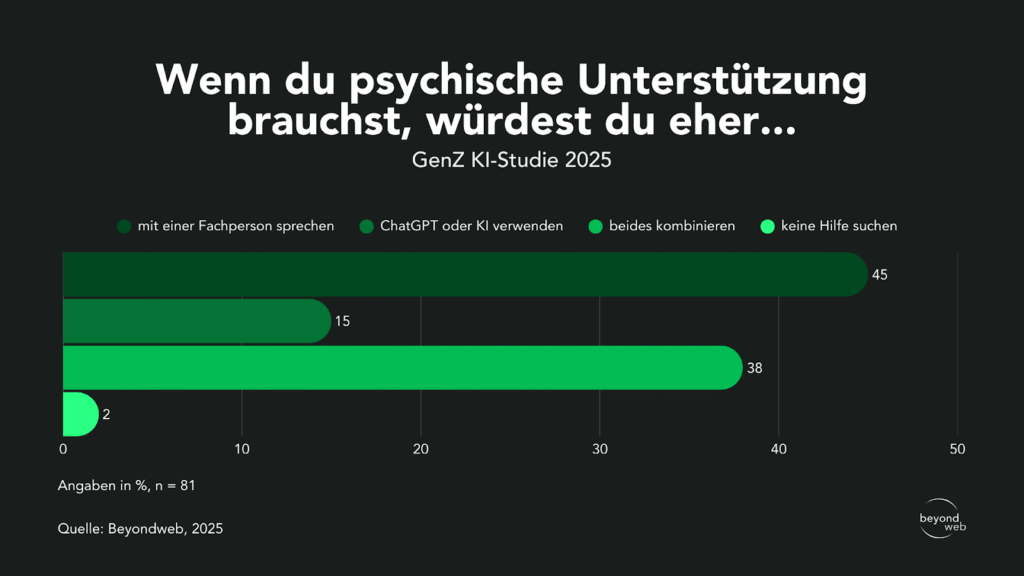

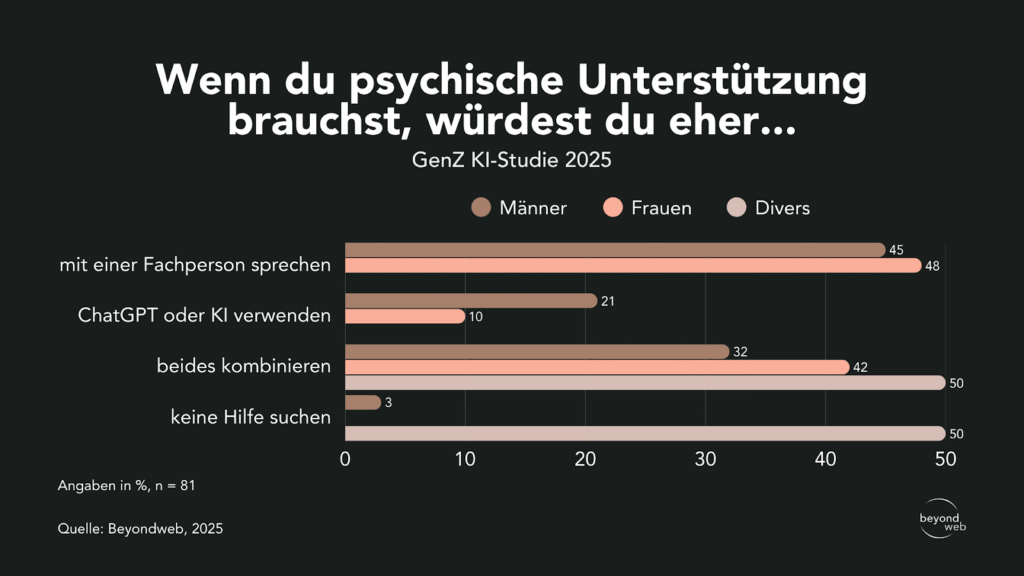

Präferenzen bei der Wahl psychischer Unterstützung

Laut unseren Studienresultaten würden sich 45 % der Befragten bei psychischer Unterstützung am ehesten an eine Fachperson wenden.

38 % gaben an, sowohl KI-Tools als auch eine Fachperson kombinieren zu wollen.

15 % würden ausschliesslich ChatGPT oder ein anderes KI-Tool nutzen, während 2 % angaben, keine Hilfe in Anspruch nehmen zu wollen.

Antworten aller Befragten auf die Frage “Wenn du psychische Unterstützung brauchst, würdest du eher: mit einer Fachperson sprechen / ChatGPT oder KI verwenden / beides kombinieren / keine Hilfe suchen”

Nach Geschlecht zeigt sich, dass 45 % der Männer und 48 % der Frauen angeben, sich an eine Fachperson zu wenden.

32 % der Männer, 42 % der Frauen und 50 % der divers-identifizierten Personen würden eine Kombination aus Fachperson und KI bevorzugen.

21 % der Männer und 10 % der Frauen würden ausschliesslich KI-Tools nutzen.

3 % der Männer, 0 % der Frauen und 50 % der divers-identifizierten Personen gaben an, keine Hilfe in Anspruch zu nehmen.

Antworten unterteilt nach dem Geschlecht auf die Frage “Wenn du psychische Unterstützung brauchst, würdest du eher: mit einer Fachperson sprechen / ChatGPT oder KI verwenden / beides kombinieren / keine Hilfe suchen”

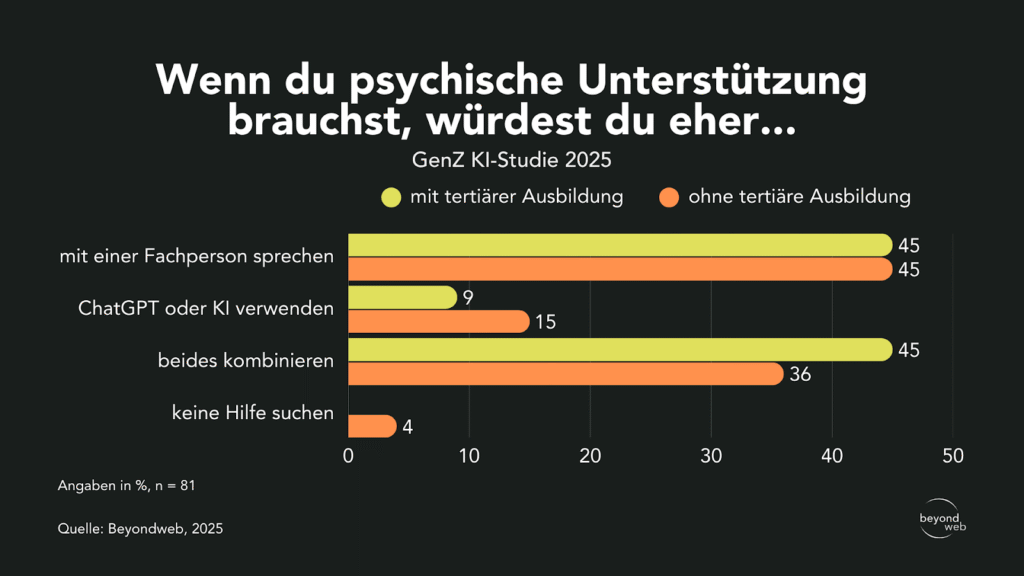

Unterteilt nach Ausbildung zeigt sich, dass 45 % der Befragten mit tertiärem Abschluss und 45 % der Personen ohne höheren Abschluss am ehesten eine Fachperson wählen würden.

Eine Kombination aus Fachperson und KI bevorzugen 36 % ohne tertiären Abschluss und ebenfalls 45 % mit höherer Ausbildung.

15 % der Personen ohne tertiäre Ausbildung und 9 % der Akademiker:innen würden ausschliesslich KI-Tools nutzen.

4 % der Befragten ohne tertiären Abschluss gaben an, keine Hilfe zu suchen, während bei den Akademiker:innen niemand diese Option wählte.

Antworten unterteilt nach dem Bildungsstand auf die Frage “Wenn du psychische Unterstützung brauchst, würdest du eher: mit einer Fachperson sprechen / ChatGPT oder KI verwenden / beides kombinieren / keine Hilfe suchen”

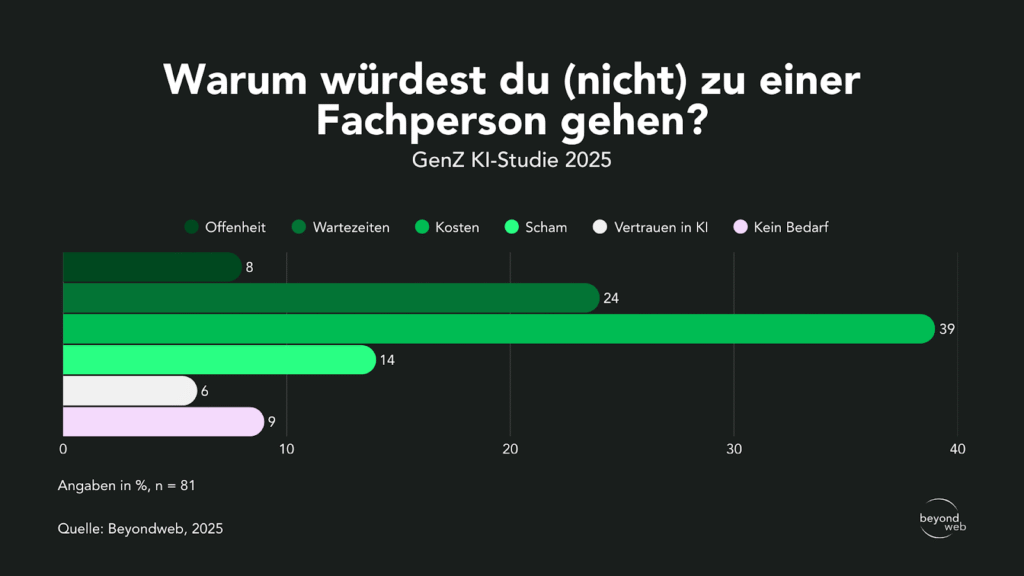

Gründe für oder gegen den Gang zu einer Fachperson bei psychischen Problemen

Laut unseren Studienresultaten geben 39 % der Befragten an, dass die Kosten der wichtigste Grund sind, nicht zu einer Fachperson zu gehen.

24 % nennen Wartezeiten als Hinderungsgrund, und 14 % geben Schamgefühle an.

9 % sehen keinen Bedarf und 6 % haben ein Vertrauen in KI-Tools, weshalb sie eher nicht zu einer Fachperson gehen würden.

Nur 8 % nannten Offenheit als Grund.

Antworten aller Befragten auf die Frage “Warum würdest du (nicht) zu einer Fachperson gehen?”

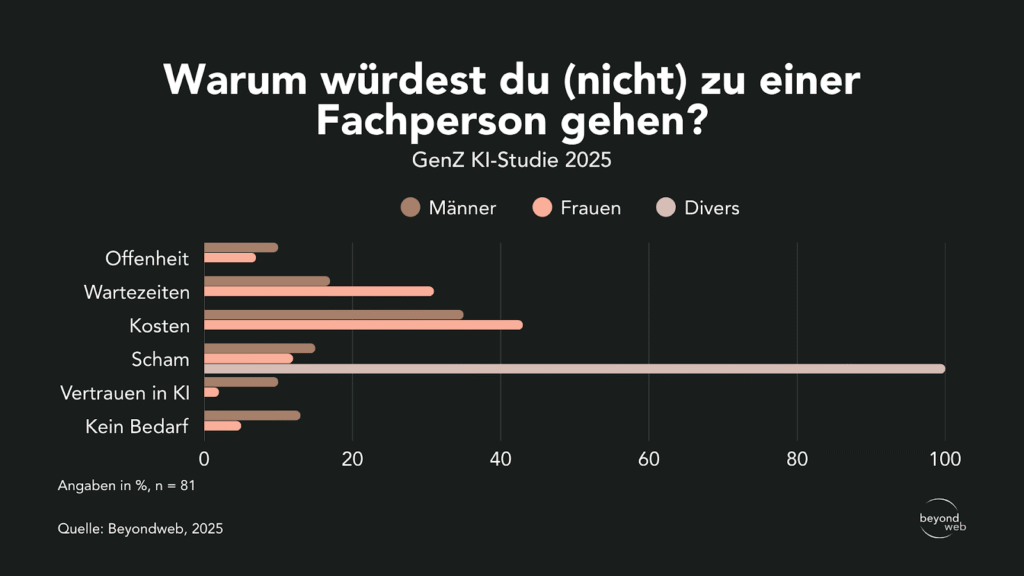

Nach Geschlecht zeigt sich, dass 35 % der Männer und 43 % der Frauen die Kosten als Haupthindernis angaben.

31 % der Frauen und 17 % der Männer nannten Wartezeiten.

15 % der Männer und 12 % der Frauen gaben Scham als Grund an.

13 % der Männer und 5 % der Frauen äusserten, dass sie keinen Bedarf sehen.

10 % der Männer und 2 % der Frauen vertrauen stattdessen auf KI-Tools.

10 % der Männer und 7 % der Frauen nannten Offenheit.

Bei den divers-identifizierten Personen gaben 100 % Scham als Grund an.

Antworten unterteilt nach dem Geschlecht auf die Frage “Warum würdest du (nicht) zu einer Fachperson gehen?”

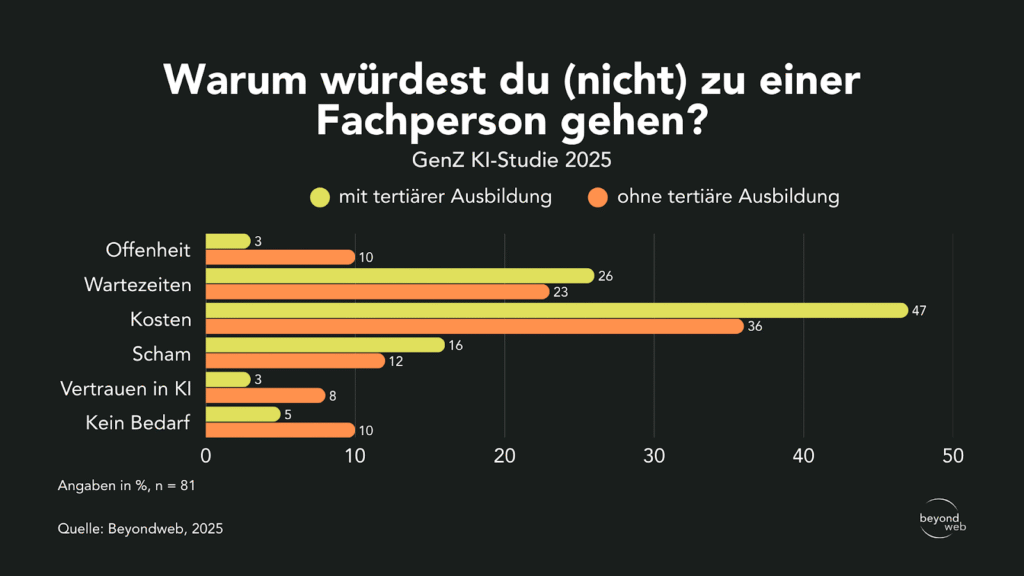

Unterteilt nach Ausbildung zeigt sich, dass 47 % der Befragten mit tertiärem Abschluss und 36 % ohne höheren Abschluss die Kosten als Hauptgrund nannten.

26 % der Akademiker:innen und 23 % der Nicht-akademiker:innen gaben Wartezeiten an.

16 % der Befragten mit tertiärer Ausbildung und 12 % ohne nannten Scham.

5 % der Akademiker:innen und 10 % der Nicht-akademiker:innen gaben an, keinen Bedarf zu haben.

8 % der Nicht-akademiker:innen und 3 % der Akademiker:innen nannten Vertrauen in KI.

3 % der Akademiker:innen und 10 % der Nicht-akademiker:innen nannten Offenheit.

Antworten unterteilt nach dem Bildungsstand auf die Frage “Warum würdest du (nicht) zu einer Fachperson gehen?”

Interpretation der Ergebnisse

Die Ergebnisse dieser qualitativen Umfrage werfen ein neues Licht auf die Rolle, die Künstliche Intelligenz (KI) im psychischen und mentalen Wohlbefinden der Generation Z in der Schweiz spielt.

Die Nutzung von KI-Tools wie ChatGPT ist in diesem Kontext nicht nur eine Randerscheinung, sondern bereits eine verbreitete Praxis.

Im Folgenden werden die zentralen Erkenntnisse näher beleuchtet und mit den gesellschaftlichen Trends sowie den Einschätzungen einer Expertin in Verbindung gebracht.

KI als alternative Anlaufstelle für emotionale Unterstützung

Fast die Hälfte (49 %) der Befragten hat bereits KI-Tools genutzt, um über persönliche oder emotionale Probleme zu sprechen.

Dieses Ergebnis belegt, dass die Gen Z in der Schweiz eine hohe Offenheit gegenüber nicht-menschlichen Gesprächspartnern in sensiblen Bereichen zeigt.

Besonders auffällig ist, dass die meisten genannten Anwendungsbereiche Entscheidungshilfe (23 %) und Beziehungsthemen (18 %) betreffen, also Felder, die sowohl kognitiv-rationales Abwägen als auch emotionale Reflexion erfordern.

Das verdeutlicht, dass KI nicht nur als Informationsquelle, sondern zunehmend als niedrigschwellige Begleiterin für Alltagsfragen und emotionale Belastungen genutzt wird.

Diese Tendenz deckt sich mit internationalen Befunden.

Eine gross angelegte Befragung unter Jugendlichen in den USA zeigt, dass rund 70 % bereits sogenannte „AI Companions“ genutzt haben; etwa ein Drittel greift sogar regelmässig darauf zurück (AP News, 2023).

Hauptgründe für diese Nutzung sind nach den Jugendlichen selbst die jederzeitige Verfügbarkeit sowie die Tatsache, dass Chatbots nicht urteilen oder stigmatisieren.

Damit entsteht ein Raum, in dem Gefühle ausgesprochen werden können, ohne dass soziale Konsequenzen befürchtet werden müssen.

Ähnliches zeigt auch eine YouGov-Erhebung, wonach über 55 % der 18- bis 29-Jährigen angeben, sich wohl dabei zu fühlen, mit KI-Chatbots über psychische Sorgen zu sprechen (Axios, 2025).

Obwohl diese Empathie technisch generiert ist, wird sie von jungen Nutzer:innen offenbar als authentisch empfunden und führt zu einem gesteigerten Vertrauen in die Interaktion.

Neben diesen quantitativen Ergebnissen liefert eine qualitative Studie weitere Hinweise auf den Nutzen von KI in emotionalen Kontexten.

In Interviews mit 19 Personen beschrieben die Befragten ihre Gespräche mit generativen KI-Chatbots als hilfreich bei Themen wie Beziehungsproblemen oder sogar bei der Traumabewältigung.

Mehrere Teilnehmende berichteten, dass sie die Interaktion als „emotional sanctuary“ empfanden, also als eine Art geschützten Rückzugsraum, in dem sie sich öffnen konnten, ohne bewertet zu werden (Nature, 2024).

Diese Beschreibungen deuten darauf hin, dass KI-Systeme nicht nur rational-informative, sondern auch psychosoziale Funktionen erfüllen können, die bislang menschlichen Interaktionen vorbehalten waren.

Neben diesen Studien, die vor allem die Präferenzen der Nutzung von KI im emotionalen Kontext zeigen, gibt es auch klare Hinweise darauf, dass KI tatsächlich wirkt.

Eine systematische Meta-Analyse zu Chatbot-gestützten Interventionen für Jugendliche und junge Erwachsene kam zu dem Ergebnis, dass diese Programme signifikante Effekte auf die Reduktion psychischer Belastungen haben (Hedges’ g ≈ –0,28).

Damit konnte gezeigt werden, dass Chatbots nicht nur kurzfristige Entlastung bieten, sondern messbar zur Verbesserung von Wohlbefinden beitragen können (PMC, 2024).

Besonders interessant ist dabei, dass die Effektstärken im Bereich leichter bis mittlerer psychischer Belastungen am deutlichsten sind, was darauf hindeutet, dass KI-Tools vor allem im präventiven und begleitenden Einsatz grosses Potenzial entfalten.

Gleichzeitig bleibt Verantwortlichkeit zentral: Während sie in der Psychotherapie klar geregelt ist, erfordern KI-Anwendungen im Gesundheitskontext klare Governance und menschliche Aufsicht.

Gender-Gap bei der Nutzung, aber nicht bei der Präferenz

Die Studienergebnisse bestätigen einen signifikanten Gender-Gap bei der allgemeinen Nutzung von ChatGPT:

Männer (52 %) greifen täglich häufiger auf das Tool zurück als Frauen (26 %), was sich auch in früheren Studien zur Technologieadoption zeigt.

Doch bemerkenswert ist, dass sich diese geschlechtsspezifischen Unterschiede auflösen, wenn es um konkrete Präferenzen bei psychologischer Unterstützung geht.

Bei der Frage, ob sie am ehesten eine Fachperson aufsuchen würden, liegen Männer (45 %) und Frauen (48 %) nahezu gleichauf.

Auch die Kombination aus Fachperson und KI wird von beiden Geschlechtern ähnlich oft genannt (Männer 32 %, Frauen 42 %).

Das deutet darauf hin, dass Frauen trotz geringerer genereller KI‑Nutzung durchaus bereit sind, KI im emotionalen Kontext zu nutzen, wenn es um Anliegen geht, die das eigene Leben betreffen.

Diese Diskrepanz zwischen allgemeiner Nutzung und situativer Offenheit verdient vertiefte Erforschung.

Dr. phil. Hannah Süss, Leitende Psychologin, Vorstandsmitglied des Kantonalverbands der Zürcher Psycholog:innen (ZüPP) und Co-Präsidentin des Leitungsgremiums Fachrat Psychotherapie (FSP), kommentiert diesen Befund:

„Grundsätzlich ist es verständlich, dass Menschen ihre Gedanken und Gefühle in einem geschützten Rahmen äussern möchten. KI-Systeme können dafür niedrigschwellig einen Raum bieten.“

Zugleich warnt sie:

„Allerdings handelt es sich bei ChatGPT nicht um eine:n Psychotherapeut:in, sondern um ein Sprachmodell ohne Bewusstsein, klinische Verantwortung oder persönliche Beziehungsgestaltung. Persönliche Probleme können zwar mitgeteilt werden, man sollte sich aber stets bewusst sein, dass eine KI keine fundierte psychologische Diagnostik oder Behandlung leisten kann.“

Süss hebt dennoch potenzielle Chancen hervor:

In Alltagsthemen wie Psychoedukation, Stressmanagement oder Motivation könne KI unterstützen; diese Funktion sieht sie als „ergänzende Tools in der Psychotherapie, wenn sie kontrolliert und verantwortungsvoll eingebunden werden“, nicht als Ersatz für professionelle Hilfe.

Gleichzeitig benennt sie klare Risiken:

„Eine zentrale Gefahr liegt in einer Scheinauthentizität. ChatGPT vermittelt sprachlich Empathie und Verständnis, hat aber kein eigenes Erleben oder klinisches Urteilsvermögen.“

Das könne zu Fehlinformationen, unangemessenen Ratschlägen und fehlender Krisenintervention führen; zudem fehle die rechtliche und ethische Verantwortung, die Psychotherapeut:innen tragen, „gerade in akuten psychischen Krisen“ hochproblematisch.

Diese Einschätzung zu Chancen und Gefahren wird durch aktuelle wissenschaftliche und journalistische Quellen deutlich gestützt:

Eine Untersuchung von Psychiatric Services zeigt, dass Chatbots bei indirekten, aber potenziell gefährlichen Suizidanfragen inkonsistent reagieren und nicht zuverlässig Krisenintervention leisten können.

Ein wörtliches Beispiel dafür: „AI has no duty to intervene in crises“ (AP News, 2025).

Auch ein Bericht über einen Jugendlichen, der sich aufgrund problematischer Chatbot-Interaktionen das Leben nahm und dessen Familie nun klagt, unterstreicht das Risiko:

KI-Sicherheitssysteme können bei längeren Interaktionen versagen.

Darüber hinaus warnt ein weiterer Fallbericht eindrücklich vor „AI psychosis“: Ein Mann geriet in eine manische Phase, weil ChatGPT seine wahnhaften Vorstellungen bestätigte, anstatt ihnen entgegenzuwirken.

Selbst bei offenkundiger psychischer Instabilität reagierte die KI mit stützender Verstärkung statt mit Unterbrechung, was seine psychische Krise verschärfte.

Diese Fälle zeigen, dass der leicht zugängliche Raum, den KI bietet, ein zweischneidiges Schwert sein kann:

Einerseits erleichtert es den Zugang zu einem nicht wertenden Ort emotionaler Offenheit, andererseits birgt es erhebliche Risiken, wenn echte therapeutische Qualifikation oder Krisenintervention fehlen.

Finanzielle Hürden und Wartezeiten treiben zur KI

Die Hauptgründe, die Gen Z-Personen davon abhalten, eine Fachperson aufzusuchen, sind Kosten (39 %) und Wartezeiten (24 %).

Diese Faktoren sind in der Praxis real und gravierend:

Laut der Föderation der Schweizer Psycholog:innen (FSP) können nur 16 % der Psycholog:innen Termine innerhalb von zwei Wochen vergeben, bei 32 % dauern Wartezeiten mindestens vier Wochen an, und 30 % nehmen aktuell keine neuen Klient:innen auf (Krucker, 2025).

Parallel dazu steigen die Gesundheitskosten in der Schweiz weiter an:

Die Gesundheitsausgaben werden laut KOF-Rechnung bis 2025 voraussichtlich über 100 Mrd. Franken steigen und im Verhältnis zum Bruttoinlandsprodukt (BIP) von 11,8 % (2023) auf 12,1 % (2025) wachsen (KOF, 2024).

Diese Entwicklung bedeutet, dass die Rahmenbedingungen für eine psychologische Behandlung zunehmend kostspielig werden, besonders durch hohe Prämien, Franchisen und Selbstbehalte.

In diesem Kontext erscheint die Nutzung von kostenfreien, anonymen und sofort verfügbaren KI-Angeboten wie ChatGPT (insbesondere in emotional belastenden Situationen) nachvollziehbar attraktiv.

Dr. phil. Hannah Süss beschreibt diese niedrigschwellige Zugänglichkeit als ein „zweischneidiges Schwert“:

Einerseits ermögliche sie Menschen, die sonst vielleicht keine Hilfe aufsuchen würden, einen ersten wichtigen Schritt.

Andererseits bestehe die Gefahr, dass dadurch der Gang zu professioneller Hilfe verzögert würde, weil Betroffene fälschlicherweise das Gefühl hätten, sie seien bereits ausreichend unterstützt.

Zudem zeigen sich geschlechtsspezifische Unterschiede:

Frauen nennen Kosten (43 %) und Wartezeiten (31 %) häufiger als Gründe, eine Fachperson nicht aufzusuchen, während Männer diese Hindernisse seltener angaben (35 % bzw. 17 %).

Das deutet darauf hin, dass Frauen Kosten- und Zugangsbarrieren stärker wahrnehmen oder davon betroffen sind und daher eher bereit sein könnten, niedrigschwellige Angebote wie KI-Tools als Alternativen in Betracht zu ziehen.

Insgesamt legen diese Befunde nahe, dass strukturelle Lücken im Zugang zur psychologischen Versorgung einen Treiber für die zunehmende Nutzung von KI im emotionalen Bereich darstellen.

Gleichzeitig verdeutlichen sie, dass digitale Angebote wie ChatGPT, obwohl sie gewisse Barrieren deutlich senken, auch sorgfältig in das Versorgungssystem eingebettet werden müssen, um Verzögerungen bei der professionellen Unterstützung zu vermeiden.

Hohes Vertrauen und Nutzen, trotz Bedenken

Die Befragten bewerten die Antworten von ChatGPT im emotionalen Kontext überwiegend als sehr hilfreich (33 %) oder hilfreich (36 %), während das Vertrauen in die KI ebenfalls hoch ausfällt.

Insgesamt 54 % stimmen zu oder stimmen voll zu, dass ihnen die Antworten von ChatGPT hilfreich erscheinen.

Ein möglicher Grund für diesen positiven Eindruck liegt in der wahrgenommenen Anonymität und Neutralität des Tools:

61 % der Gen Z-Befragten finden es angenehm, mit ChatGPT über Dinge zu sprechen, die sie Menschen nicht sagen würden, und erkennen es als neutraler und weniger wertend als Menschen an.

Diese Einschätzungen spiegeln sich auch in wissenschaftlicher Forschung wider:

In einem systematischen Review heisst es, dass konversationelle KI oft als nicht wertend wahrgenommen wird.

Diese Wahrnehmung steigert sowohl das Vertrauen der Nutzer als auch deren Bereitschaft, sich zu öffnen und persönlichen Fragen nachzugehen (Cha, 2023).

Weitere Studien zeigen, dass Anonymität und Vertraulichkeit durch KI das Vertrauen stärken, insbesondere bei Personen, die Hemmungen oder Stigmata beim persönlichen Austausch empfinden (Khawaja & Bélisle-Pipon, 2023).

Ein systematischer Überblick über Nutzerbewertungen von mentalen Gesundheits-Apps greift diesen Befund auf:

In Online-Feedbacks rangiert „alternative oder ergänzende Rolle zur Therapie“ als ein wichtiges Thema und ist ein Hinweis darauf, dass viele die KI-Tools als kompetente, ergänzende Unterstützung zum klassischen Setting wahrnehmen (Shan, 2022).

Trotz dieses hohen Vertrauens bestehen erhebliche Datenschutz- und Sicherheitsbedenken:

38 % der Befragten machen sich grosse Sorgen, dass ihre Eingaben gespeichert oder missbraucht werden könnten.

Diese scheinbare Diskrepanz, also hohes Vertrauen und Nutzengefühl bei gleichzeitigen Bedenken, deutet auf eine pragmatische Abwägung hin:

Die Gen Z erkennt den unmittelbaren Nutzen in der anonymen, sofortigen Unterstützung und ordnet diesen höher als potenzielle Risiken ein.

Diese ambivalente Haltung ist charakteristisch für eine Generation, die digitale Tools kritisch und bewusst nutzt:

Sie schätzt die Vorteile, bleibt sich aber der Grenzen und Risiken bewusst.

KI als Ergänzung, nicht als Ersatz

Obwohl 15 % der Befragten angaben, ausschliesslich KI‑Tools für psychologische Unterstützung zu nutzen, verdeutlichen die übrigen Ergebnisse eine klare Tendenz:

KI wird in erster Linie als Ergänzung zur traditionellen Hilfe betrachtet, nicht als Ersatz.

Bereits fast 40 % der Befragten würden eine Kombination aus KI und Fachperson in Anspruch nehmen, während 45 % sich weiterhin am ehesten an eine Fachperson wenden würden.

Das unterstreicht, dass die Gen Z sich der Grenzen technologischer Angebote im therapeutischen Kontext bewusst ist; sie nutzt KI dort, wo sie sinnvoll erscheint, respektiert gleichzeitig die Relevanz professioneller Unterstützung.

Internationale Quellen belegen diesen Ansatz:

Ein Artikel in Teen Vogue beschreibt, wie Jugendliche KI-Tools wie ChatGPT, Woebot und Wysa zwar als wertvolle Ergänzung nutzen, sei es zur Unterstützung bei Essstörungen oder beim Aufrechterhalten von Routinen, aber stets unterstreichen, dass menschliche Betreuung weiterhin wichtig bleibt.

Einer der Jugendlichen fasst es zusammen: „As much as I like AI for some of those reasons, I also think it’s important to see therapists … You just need that one‑on‑one communication…” (Tarpley, 2025).

Auch die Reuters-Berichterstattung unterstreicht die Rolle von KI als pragmatische Überbrückung, etwa in Regionen mit eingeschränkter psychotherapeutischer Versorgung.

Sie dient als zugängliche, wenn auch unvollkommene Unterstützung, keinesfalls als dauerhafte Retterin in der Krise.

Rechtliche Expert:innen warnen ebenso davor, KI dauerhaft statt menschlicher Empathie einzusetzen, denn sie kennen weder den emotionalen Tiefgang noch die therapeutische Bindung, die nur Menschen vermitteln können (Richter, 2025).

Diese Erkenntnisse geben dem Ergebnis der Studie eine fundierte Basis:

Die Gen Z ist offen für KI als unterstützendes Element, erkennt aber klar den Mehrwert professioneller menschlicher Hilfe.

Diese Haltung ist relevant für Debatten über die Zukunft der psychischen Gesundheitsversorgung, insbesondere in einer Zeit, in der digitale und humanistische Formen der Unterstützung zunehmend miteinander vernetzt werden sollten, um wirklich wirksame, ethisch verantwortbare Angebote zu schaffen.

Schlusswort

Die Ergebnisse dieser Studie zeigen eindrücklich, dass Künstliche Intelligenz (KI) bereits heute eine spürbare Rolle im psychischen und emotionalen Alltag der Generation Z in der Schweiz spielt.

Fast die Hälfte der Befragten hat ChatGPT bereits für persönliche oder emotionale Anliegen genutzt.

Das ist ein Hinweis darauf, dass KI nicht nur als technisches Hilfsmittel, sondern auch als niedrigschwellige Anlaufstelle wahrgenommen wird.

Besonders auffällig ist die ambivalente Haltung der Befragten:

Auf der einen Seite bewerten sie die Antworten von ChatGPT mehrheitlich als hilfreich und vertrauenswürdig, schätzen die Anonymität und Neutralität des Tools und nutzen es zunehmend in sensiblen Kontexten.

Auf der anderen Seite bestehen erhebliche Bedenken hinsichtlich Datenschutz, Verantwortung und fehlender therapeutischer Kompetenz.

Diese Spannung zwischen Vertrauen und Skepsis ist charakteristisch für eine Generation, die digitale Innovationen offen annimmt, gleichzeitig aber kritisch reflektiert.

Die Ergebnisse verdeutlichen zudem, dass strukturelle Faktoren wie hohe Kosten und lange Wartezeiten im Schweizer Gesundheitssystem einen entscheidenden Einfluss auf die Nutzung von KI haben.

In diesem Kontext wird ChatGPT als pragmatische, jederzeit verfügbare Unterstützung wahrgenommen.

Nicht als Ersatz, sondern als Ergänzung zur professionellen Hilfe.

Damit bestätigt sich auch international ein klarer Trend: KI wird genutzt, um Barrieren zu überwinden, doch die Bedeutung menschlicher Begleitung bleibt unbestritten.

Für Wissenschaft, Politik und Praxis ergibt sich daraus eine doppelte Aufgabe:

Einerseits gilt es, Chancen von KI-gestützten Angeboten verantwortungsvoll zu nutzen, indem sie in bestehende Versorgungssysteme integriert werden.

Andererseits müssen die Risiken klar adressiert werden, um Vertrauen und Sicherheit langfristig zu gewährleisten.

Die Studie macht deutlich:

Die Generation Z in der Schweiz erkennt die Potenziale von KI, ist aber zugleich sensibel für deren Grenzen.

Damit eröffnet sich ein Raum für Innovation, in dem digitale und traditionelle Formen der psychischen Unterstützung zusammengedacht werden müssen.

Dies kann den Weg zu einem zeitgemässen, zugänglichen und zugleich verantwortungsvollen Umgang mit mentaler Gesundheit ebnen.

Quellenverzeichnis

AP News (2023, Dezember 27): Teens turn to ‘AI companions’ for support, raising concerns among parents experts https://apnews.com/article/ai-companion-generative-teens-mental-health-9ce59a2b250f3bd0187a717ffa2ad21f

AP News (2025, Mai 10): AI chatbots sometimes miss suicide risks, experts warn https://apnews.com/article/ai-chatbots-selfharm-chatgpt-claude-gemini-da00880b1e1577ac332ab1752e41225b

Axios (2025, März 23): This empathy chatbot just passed the Turing test for therapists https://www.axios.com/2025/03/23/empathy-chatbot-turing-therapist

Frontiers (2023): Artificial intelligence chatbots in mental health: A review of the evidence, Frontiers in Digital Health, 5, 1278186 https://www.frontiersin.org/journals/digital-health/articles/10.3389/fdgth.2023.1278186/full

KOF ETH Zürich (2024, November 21): Gesundheitsausgaben steigen auf über 100 Mrd. Franken https://kof.ethz.ch/news-und-veranstaltungen/medien/medienmitteilungen/2024/11/gesundheitsausgaben-steigen-auf-ueber-100-mrd-franken.html

Nature (2024): Talking to machines: Generative AI chatbots as emotional companions, Mental Health Research, 3, Article 97 https://www.nature.com/articles/s44184-024-00097-4

New York Post (2025, August 29): Experts call for AI regulation as parents sue over teen suicides https://nypost.com/2025/08/29/tech/experts-call-for-ai-regulation-as-parents-sue-over-teen-suicides

Psychotext (2025): Studie: Wartezeiten bei Psycholog:innen in der Schweiz https://www.psychotext.ch/studien/wartezeit-bei-psychologinnen

Reuters (2025, August 23): ‘It saved my life’: People are turning to AI therapy https://www.reuters.com/lifestyle/it-saved-my-life-people-turning-ai-therapy-2025-08-23

Tarpley, J. (2025, Januar 15): Teens are turning to AI therapy chatbots to cope with eating disorders https://www.teenvogue.com/story/ai-therapy-chatbot-eating-disorder-treatment

US National Library of Medicine (2022): Conversational agents in mental health: Systematic review, JMIR Mental Health, 9(11), e9758643 https://pmc.ncbi.nlm.nih.gov/articles/PMC9758643

US National Library of Medicine (2023): Efficacy of chatbot-based mental health interventions: A systematic review and meta-analysis, Journal of Medical Internet Research, 25, e10625083 https://pmc.ncbi.nlm.nih.gov/articles/PMC10625083

US National Library of Medicine. (2024): Effectiveness of chatbot-based interventions for young adults: A meta-analysis, Psychiatric Services. https://pmc.ncbi.nlm.nih.gov/articles/PMC12261465/

Wall Street Journal (2025, April 2): ChatGPT linked to manic episodes: Psychologists warn of “AI psychosis” https://www.wsj.com/tech/ai/chatgpt-chatbot-psychology-manic-episodes-57452d14

Anhang

Demografie der Befragten